Schlagwort: google-webmaster-tools

Heute in den Kurzmeldungen: Schaar stellt zwei Forderungen wegen Street View, Video-Sitemaps, Kritik am Google TV und Schmidt über Datenschutz bei Jugendlichen.

Der Bundesdatenschutzbeauftragte Peter Schaar hat sich in der Sache rund um Street View zu Wort gemeldet. Er fordert die Einrichtung eines Widerspruchsregisters und Profilbildungsverbot.

Seit einiger Zeit bietet Google auch Video-Sitemaps an. Im Webmaster Tools-Labs hat Google nun einen Abschnitt für einige experimentelle Funktionen um diese Sitemaps geschaffen. So zeigt man hier an, wenn die Thumbnails zu klein sind, der Zugriff durch die Robots.txt geblockt wird. Details

Google will im Herbst die ersten Geräte mit Google TV ausliefern. Mit diesen Geräten soll es auch möglich sein alte Episoden der Serie direkt am TV anzuschauen. Doch nun wehren sich die ersten US-Sender und wollen ihre Mediatheken nicht für Google öffnen. Sie fürchten, dass ihr Inhalte in der Flut untergehen. Weiteres bei heise.

Googles Chef Eric Schmidt rät jungen Menschen, die ihre Jugendsünden aus dem Internet haben wollen, sich einen neuen Namen zu zu legen und so mit einer weißen Weste ins Leben starten.

Der Bundesdatenschutzbeauftragte Peter Schaar hat sich in der Sache rund um Street View zu Wort gemeldet. Er fordert die Einrichtung eines Widerspruchsregisters und Profilbildungsverbot.

Es kann nicht angehen, dass Widerspruchsrechte vom Goodwill der jeweiligen Unternehmen abhängen. Nicht akzeptabel wäre es auch, dass die Betroffenen separat gegenüber allen Anbietern entsprechender Dienste der Veröffentlichung widersprechen müssen. Durch ein zentrales Widerspruchsregister könnte sichergestellt werden, dass ein einziger Widerspruch die Betroffenen gegen die Veröffentlichung ihrer personenbezogenen Daten im Internet schützt. Ein solches Widerspruchsregister könnte zum Beispiel bei der im Koalitionsvertrag vorgesehenen Stiftung Datenschutz eingerichtet werden,so Schaar in einer Mitteilung.

Seit einiger Zeit bietet Google auch Video-Sitemaps an. Im Webmaster Tools-Labs hat Google nun einen Abschnitt für einige experimentelle Funktionen um diese Sitemaps geschaffen. So zeigt man hier an, wenn die Thumbnails zu klein sind, der Zugriff durch die Robots.txt geblockt wird. Details

Google will im Herbst die ersten Geräte mit Google TV ausliefern. Mit diesen Geräten soll es auch möglich sein alte Episoden der Serie direkt am TV anzuschauen. Doch nun wehren sich die ersten US-Sender und wollen ihre Mediatheken nicht für Google öffnen. Sie fürchten, dass ihr Inhalte in der Flut untergehen. Weiteres bei heise.

Googles Chef Eric Schmidt rät jungen Menschen, die ihre Jugendsünden aus dem Internet haben wollen, sich einen neuen Namen zu zu legen und so mit einer weißen Weste ins Leben starten.

Heute in den Kurzmeldungen: WaveThis!, Google schlägt soft 404-Fehler vor und die Türkei sperrt Google.

Google hat das erstellen von Waves mit Inhalten aus Webseiten vereinfacht. Neben einem Bookmarklet für alle Browser, gibt es für Chrome eine Erweiterung und Webmaster können einen Share Icon zu ihrer Seite hinzufügen.

In den Webmaster Tools weist Google nun auch auf Seiten hin, die möglicherweise 404-Content enthalten. Zum soft 404 kommt es, wenn der Server mit 200 antwortet, obwohl der Inhalt eigentlich nicht existiert. Details

Die Türkei hat zahlreiche Google Services gesperrt. Bereits seit 2008 kann man nicht auf YouTube zugreifen, da dort Videos veröffentlicht wurden, die den Staatsgründer verunglimpft haben sollen. Laut International Business Times sind nun auch Google Docs, Feedburner, App Engine, Translate, Books und Analytics gesperrt.

Google hat das erstellen von Waves mit Inhalten aus Webseiten vereinfacht. Neben einem Bookmarklet für alle Browser, gibt es für Chrome eine Erweiterung und Webmaster können einen Share Icon zu ihrer Seite hinzufügen.

In den Webmaster Tools weist Google nun auch auf Seiten hin, die möglicherweise 404-Content enthalten. Zum soft 404 kommt es, wenn der Server mit 200 antwortet, obwohl der Inhalt eigentlich nicht existiert. Details

Die Türkei hat zahlreiche Google Services gesperrt. Bereits seit 2008 kann man nicht auf YouTube zugreifen, da dort Videos veröffentlicht wurden, die den Staatsgründer verunglimpft haben sollen. Laut International Business Times sind nun auch Google Docs, Feedburner, App Engine, Translate, Books und Analytics gesperrt.

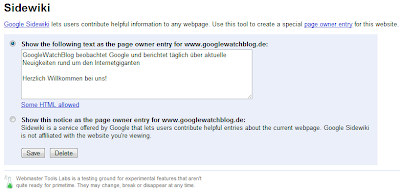

Google hat in den Labs Bereich der Google Webmaster Tools Sidewiki integriert. Über diesen kann der Nutzer den Webmaster-Eintrag bearbeiten.

Der Webmaster-Eintrag in Sidewiki wird als Erstes angezeigt, wenn ein Nutzer die Sidewiki-Kommentare öffnet. Bisher konnte der Webmaster diese lediglich bearbeiten, wenn er die Google Toolbar oder die Sidewiki Erweiterung für Google Chrome installiert hat.