Schlagwort: google-research

Das Google Research-Team hat mal wieder ein sehr interessante Tool veröffentlicht: Die Abteilung Spracherkennung scheint mittlerweile so sehr auf die eigene Technologie zu vertrauen, dass man jetzt ein Gadget für iGoogle veröffentlicht hat mit dem die Videos aller US-Präsidentschaftskandidaten nach einzelnen Wörtern durchsucht werden können.

Das Google Research-Team hat mal wieder ein sehr interessante Tool veröffentlicht: Die Abteilung Spracherkennung scheint mittlerweile so sehr auf die eigene Technologie zu vertrauen, dass man jetzt ein Gadget für iGoogle veröffentlicht hat mit dem die Videos aller US-Präsidentschaftskandidaten nach einzelnen Wörtern durchsucht werden können.

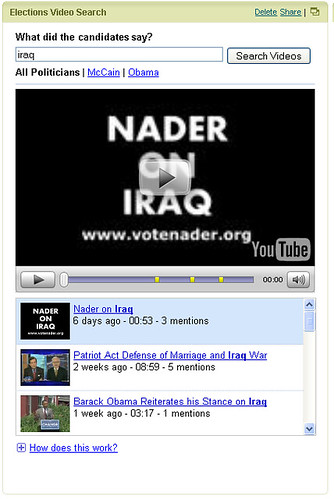

Das Gadget ist ganz einfach zu bedienen: Einfach das gewünschte Wort einzugeben und eventuell noch auswählen ob nur Videos von Obama oder McCain oder aller Kandidaten durchsucht werden soll. Am unteren Ende des Gadgets wird eine Liste mit Videos angezeigt in denen die Wörter vorkommen. Spielt man das Video ab, kann man direkt zu der Stelle springen an dem das Wort fällt. Die entsprechende Position ist im Video gelb markiert. Zum Startschuss des großangelegten Tests werden nur Videos der Präsidentschaftskandidaten auf YouTube, oder YouChoose durchsucht. Google gibt zwar an, dass das ganze vielleicht nicht 100%ig zuverlässig funktioniert, aber scheint sich doch so sicher zu sein, das ganze bei einem doch relativ wichtigen Thema auszuprobieren und auch das Beta-Label sucht man in diesem Fall vergeblich. Getestet und trainiert wurde die Spracherkennung schon seit langer Zeit mit Goog-411. Durch dieses Angebot hat Google nahezu jeden Dialekt und Stimmlage und auch verschiedene Aussprachen bereits aufgenommen und untersucht. Ich denke wenn das ganze jetzt bei Obama & Co. gut funktioniert, könnte man dieses Feature demnächst auch standardmäßig bei YouTube finden. Sicherlich wird es eine ganze Zeit lang dauern _alle_ Videos bei YouTube nach bestimmten Texten und Wörtern zu durchsuchen und entsprechend zu indizieren, aber ich könnte wetten dass das YouTube-Team bereits damit begonnen hat. Wenn die Spracherkennung wirklich reibungslos funktioniert ist das doch mal wieder eine schöne Innovation mit der Tags & Co. praktisch schon überflüssig werden - wenn entsprechend viel im Video gesprochen wird. » Gadget zu iGoogle hinzufügen » Ankündigung im Google-Blog