Google verrät: So funktioniert die „beste Smartphone-Kamera der Welt“ im Pixel 2 [Video]

Vor wenigen Tagen hat Google die neuen Pixel 2-Smartphones vorgestellt und hat sich auch in diesem Jahr wieder stark auf die Fähigkeiten der Kamera konzentriert. Sowohl bei Testern als auch in Benchmarks ist derzeit unbestritten, dass Googles Smartphones die besten Fotos dieser Geräteklasse liefern – aber wie funktioniert das? Ein sehr gut gemachtes Video gibt nun einen tiefen Einblick in die Hardware und die Funktionsweise dieser Kamera.

Schon im vergangenen Jahr hatte Google die beste Smartphone-Kamera der Welt in die eigenen Geräte integriert und hat uns eine kleinen Einblick darin gegeben, wie sie genau funktioniert. In diesem Jahr hat man aber noch einmal einen drauf gelegt und liefert nun noch deutlich bessere Ergebnisse als zuvor. In einem Benchmark ist die Kamera mittlerweile wieder als beste jemals getestete Smartphone-Kamera hervorgegangen und die Konkurrenz wird sich anstrengen müssen, um diesen Bereich mit den nächsten Geräten wieder zurück zu erobern. Wer sich selbst davon überzeugen möchte, sollte sich diese Galerie ansehen.

Jetzt hat Google auf dem Sub-Kanal Nat and Friends ein 9-minütiges Video veröffentlicht, in dem man auf die Geheimnisse der Kamera eingeht und das Zusammenspiel von Hardware und Software mit sehr einfachen Worten und auch vielen aufschlussreichen Grafiken und Animationen zeigt. Selbst wer des englischen nicht ganz so mächtig ist und keinen Einblick in die Kamera-Materie hat (so wie ich), wird leicht verstehen wie das ganze funktioniert. Das Video ist unterhaltsam gemacht und zeigt auch wiederum mit vielen Beispiele noch einmal die Qualität der Kamera.

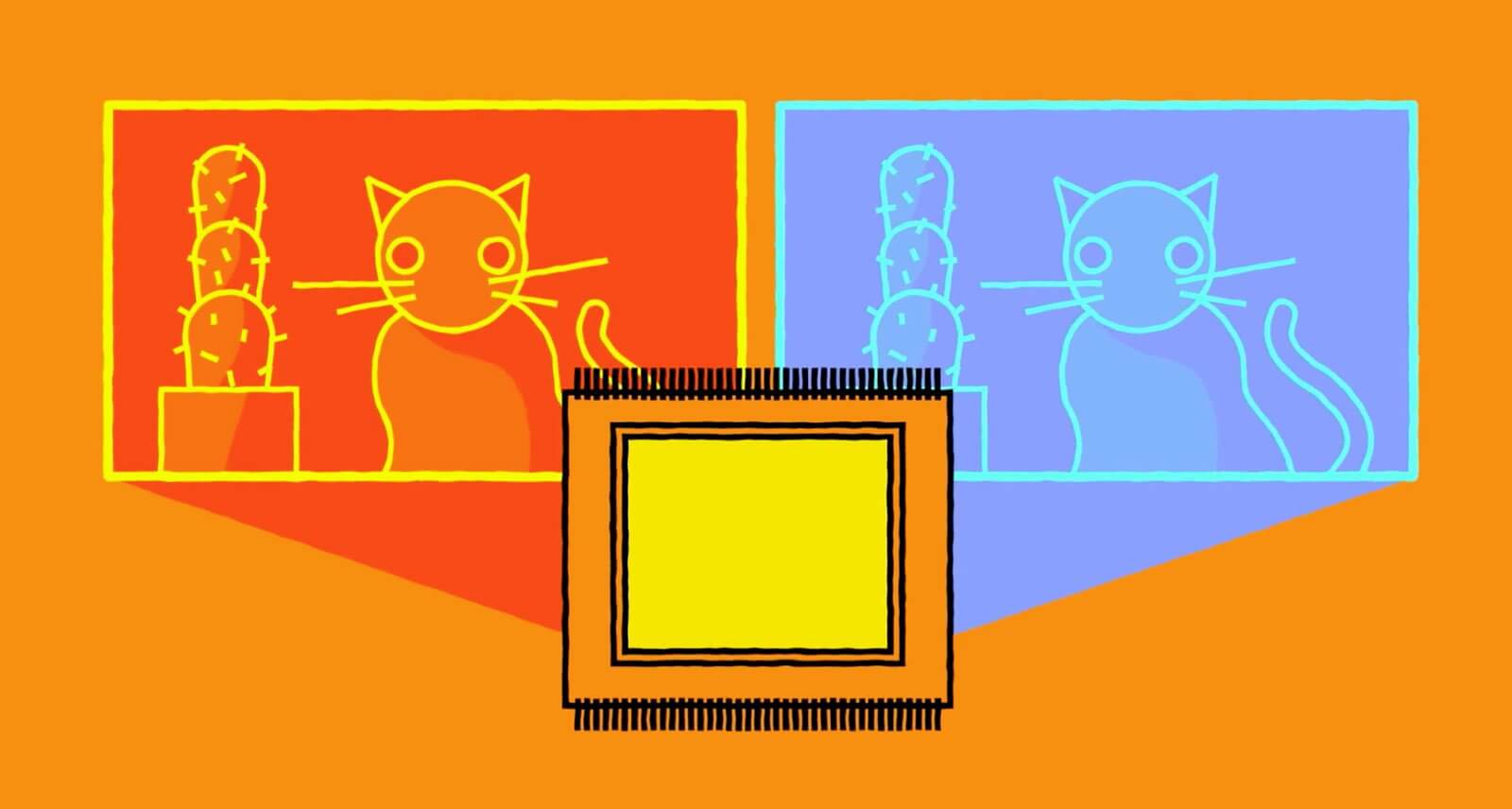

Das erste Geheimnis liegt natürlich in der Hardware, denn Google hat in Zusammenarbeit mit seinen Partnern eine Kamera entwickelt, in der gleich sechs Linsen hintereinander Platz finden, die für einen perfekten Autofokus sorgen. Außerdem verfügt die Kamera über eine Hardware-Stabilisierung, was im Zusammenspiel mit den sechs Linsen für ein scharfes und nicht verwackeltes Bild sorgt. Außerdem verfügt jeder Pixel auf dem Sensor über einen Links- und Rechts-Kanal, so dass wie beim menschlichen Auge praktisch zwei Bilder wahrgenommen und dann zusammengeführt werden.

Das klingt nun recht simpel, erfordert aber jede Menge Technologie um daraus wieder die Fotos zu formen, die am Ende als Ergebnis herauskommen. Dadurch wird es Google aber möglich, weiterhin nur eine Kamera zu verbauen und dennoch bessere Ergebnisse als die Dual-Kameras der Konkurrenz zu liefern.

Hat die Kamera dann erst einmal die Bilder aufgenommen, kommt der Google Image Chip für die Nachbearbeitung ins Spiel. Dieser übernimmt den HDR+ Modus für das Zusammenführen vieler Einzelaufnahmen zu einem einzigen Bild und setzt dabei auf eine mächtige und von Künstlichen Intelligenzen trainierte Bilderkennung. Außerdem kommt auch hier noch einmal eine Bild-Stabilisierung zum Einsatz, bei der nicht nur die Bilder verglichen sondern auch auf die Daten des Smartphone-Gyroskops- und Bewegungssensors zugegriffen wird. Dort dürften wohl auch einige Erfahrungen mit der Motion Stills-App eingeflossen sein.

Der nächste neue Bereich ist der Portrait Modus, mit dem die Person oder der Gegenstand im Vordergrund scharf gestellt und der Hintergrund automatisch leicht unscharf gestellt wird. Das wird nur dadurch möglich dass in der Kamera noch ein zusätzlicher Tiefen-Sensor schlummert der eine genaue Tiefen-Analyse liefert und so erst erkennen kann, was im Hintergrund und was im Vordergrund ist.

Als letztes darf man aber natürlich auch nicht die Software-Seite mit der Google Camera vergessen, die ebenfalls nochmal ihr übriges tut und das beste aus dem Foto herausholt. Die HDR+ Version der 2016er Pixels bekommt ihr übrigens hier und könnt damit in vielen Fällen auch aus eurem Smartphone noch etwas mehr herausholen.

» Pixel 2: Unbearbeitete Beispiel-Fotos von der Smartphone-Kamera

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter