Googles

Webmasterzentrale hat wieder einige interessante Updates spendiert bekommen: Dabei handelt es sich sowohl um erweiterte Auswertungen und Statistiken als auch einige Einstellungsmöglichkeiten für die eigene Domain. So kann jetzt z.B. eingestellt werden wie oft der GoogleBot auf der eigenen Webseite vorbeischauen soll - allerdings alles auf eigene Gefahr.

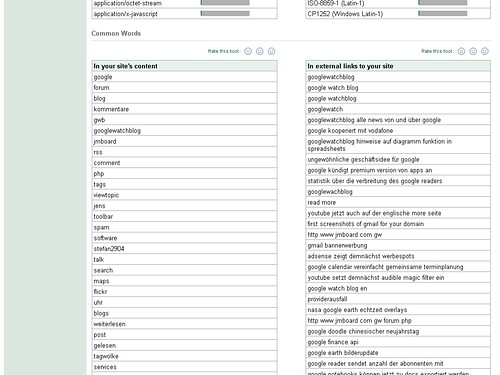

GoogleBot-Aktivitäten

In 3 Diagrammen kann der Webmaster jetzt sofort sehen wieviele Webseiten der Bot jeden Tag besucht, wieviele Datenmengen er dabei herunterlädt und wie lange er dafür ungefährt braucht. Wenn diese Werte fallend statt steigend sind sollte man sich Sorgen machen, zumindest als Content-Lieferer - denn dann sind irgendwelche Webseiten nicht mehr richtig verlinkt.

Unglaubwürdige Werte

Bei mir tauchen hier allerdings einige sehr merkwürdige Werte auf die ich nicht so ganz glauben kann. Laut Statistik crawlt Google jeden Tag 4241 Seiten in diesem Blog - okay, das ist soweit möglich - aber nicht jeden Tag. Und jetzt der schlimmste Wert: Google lädt

jeden Tag 188,93 MB an Daten von diesem Blog herunter. Zur Spitzenzeit waren es sogar

414.727 MB. Soll ich das wirklich glauben? Das würde die Traffic-Grenzen des Servers nämlich brechen... Nur bei der Antwortzeit muss ich Google leider recht geben, knapp 1 Sekunde pro Seite - es steht wohl so langsam der Wechsel auf einen leistungsfähigeren Server an...

Crawl-Geschwindigkeit einstellen

Jeder Webmaster hat jetzt die Wahl zwischen schnellem, normalem und langsamen Crawling der eigenen Webseite. Wer einen starken Server besitzt sollte hier natürlich auf Faster stellen, denn so kann man schon innerhalb von 24 im Google-Index auftauchen, was bei aktuellen Themen sehr wichtig ist - langsamere Server oder Seiten die nur selten upgedatet werden können den Bot auch auf langsam einstellen. Alle anderen sollten bei normal bleiben.

Standardmäßig stellt Google einen Wert ein der dem Server angemessen ist. Anhand der Antwortzeiten stellt der Bot fest ob der Server vom GoogleBot überlastet ist oder nicht und verändert die Geschwindigkeit von sich aus. Ich wusste garnicht dass der Bot so intelligent ist, aber es ist nett von Google dass sie nicht die gesamte Bandbreite eines Servers fressen wollen ;-)

Erweiterte Bildersuche

Mit einer kleinen CheckBox kann jeder Webmaster einwilligen seine Fotos durch Programme wie den

Google Image Labeler weiter sortieren und auswerten zu lassen. Was passiert wenn die Box deaktiviert ist (was sie standardmäßig auch ist) weiß ich nicht, ich denke in der Bildersuche tauchen die Fotos trotzdem alle auf - ansonsten könnte diese demnächst sehr leer werden.

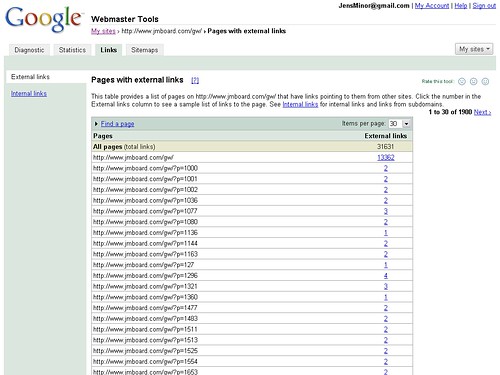

Anzahl der Sitemap-URLs

In der Sitemap-Übersicht wird nun auch angezeigt wieviele URLs sich in der eigenen Sitemap befinden. Leider kann keine Liste mit den eingetragenen URLs angesehen werden, denn das wäre noch sehr viel interessanter. Bei mir sind zur Zeit knapp 1800 URLs eingetragen, das deckt sich sehr grob mit der Anzahl der Artikel in diesem Blog. Die Anzahl der Artikel liegt derzeit bei knapp 2.000.

Fazit

Wieder einmal sehr interessante Neuerungen, vorallem die GoogleBot-Statistiken und die dazugehörige Geschwindigkeitseinstellung. Ganz unbewusst werden Webmaster so langsam gezwungen sich bei Sitemaps zu registrieren und eine eigene Sitemap anzulegen - denn ohne diese können die ganzen Einstellungen, die sicherlich irgendwann überlebenswichtig für eine Webseite sind, nicht vorgenommen werden. Außerdem wird der Trend, nur noch für Google zu optimieren, noch weiter ausgebaut - kluger Schachzug, aber schlecht für die Konkurrenz - die müssen nun erstmal nachziehen.

»

Ankündigung im Webmaster Tools Blog