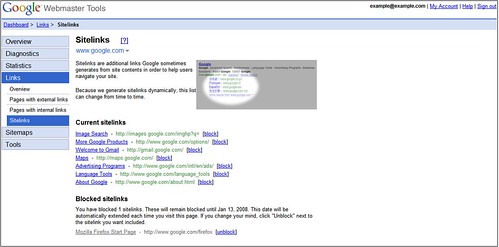

Wenn der GoogleBot bei einer Webseite eine bestehende Struktur erkennt und diese als relevant einstuft, besteht die Möglichkeit dass die Navigation der Seite schon innerhalb der Suchergebnisse angezeigt wird. Auf diese so genannten Sitelinks hatte man bisher keinen Einfluss, doch das ändert sich mit der neuesten Version der

Webmaster Tools. Außerdem können jetzt historische Suchanfragen ausgewertet werden.

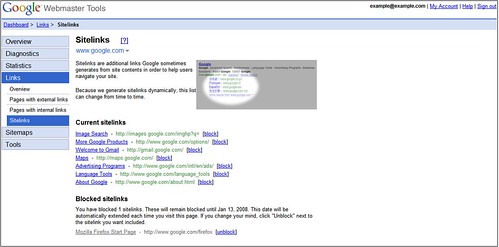

Sitelinks

Zwar werden die Sitelinks nur angezeigt wenn sich der GoogleBot absolut sicher ist dass die Links relevant sind und wirklich zur Navigation gehören, aber dennoch kann es vorkommen dass in der Praxis dann unpassende Links auftauchen, wie z.B. zu einzelnen Beiträgen auf einer Seite. Um dies zu verhindern können Links jetzt auch aus dieser Liste entfernt werden.

Um einen Link zu entfernen müsst ihr einfach nur auf "block" klicken und bei der nächsten Suchanfrage ist der Link aus der Liste verschwunden. Die Webseite kann aber jederzeit wieder mit einem Klick in die Liste aufgenommen werden. Mit der Funktion werden sich sicherlich einige unsinnige Links entfernen lassen, die Frage ist nur welcher Webmaster das will - warum sollte man freiwillig einen Link von google.com entfernen? Auch wenn es nur eine Unterseite ist, Traffic ist Traffic... Das ausblenden der Links dürfte sich also in Grenzen halten.

Leider ist es nicht möglich einen neuen Link hinzuzufügen oder bestehende zu bearbeiten. Dass es so eine Funktion nicht gibt ist verständlich, sonst wäre die Suchergebnisseite voll mit "HIER KLICKEN!!!" und co. Aber eventuell könnte man eine "Link prüfen" Funktion einbauen mit der man dem GoogleBot die Arbeit erleichtert. Ich würde für den Blog hier z.B. vorschlagen dass das

Wiki und das

Forum dort auftauchen sollten und der Bot prüft ob diese Seite relevant sind und schaltet sie dann später frei. Denkt mal drüber nach Googler ;-)

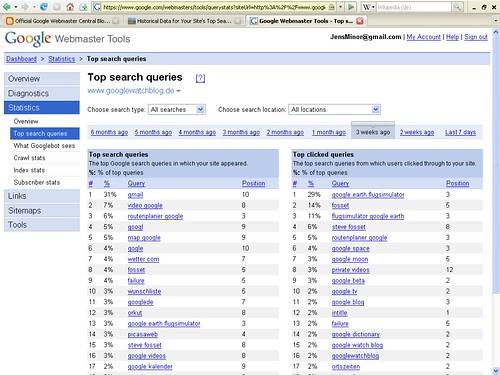

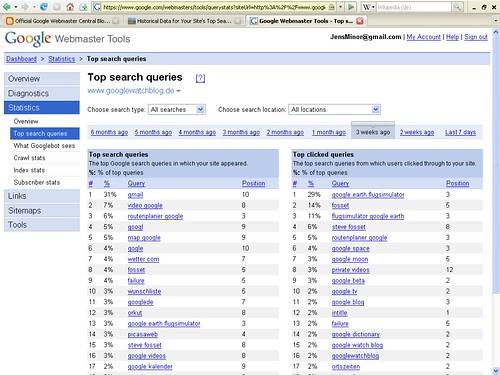

Top Keywords

Ab sofort werden nicht mehr nur die aktuellen Top Keywords angezeigt, sondern auch die der Vergangenheit. Zur Zeit stehen die Zeitabschnitte 7 Tage, 2 Wochen, 1 Monat, 2 Monate, 3 Monate, 4 Monate, 5 Monate und 6 Monate zur Verfügung - weiter zurück scheinen die Daten wohl noch nicht zu reichen. Zumindest beim GWB reichen sie sogar nur 3 Wochen zurück. Die Keywords können zusätzlich nach Suchtyp und der lokalen Google-Suche eingeschränkt werden.

Die Navigation dieses Keywords-Archiv erinnert ein wenig an das von

Google Finance, da über der aktuellen Anzeige eine Art Schieberegler angezeigt wird - allerdings lässt sich dieser nicht verschieben. Das könnte aber bedeuten dass die Navigation demnächst ein wenig interaktiver gestaltet wird und es zu bestimmten Keywords eine Verlaufsgrafik geben wird. Wäre doch wirklich spannend wie sich ein Keyword im Laufe der Zeit entwickelt hat und welches sehr beständig immer wieder User auf die Seite lockt.

»

Ankündigung im Webmaster Central Blog

[

Google OS]