Gemini: Google zeigt spektakuläre KI-Demo – Project Astra analysiert Livebild mit Smart Glasses (Video)

Google hat das KI-Modell Gemini von Beginn an als multimodales Produkt entwickelt, nutzt diese Fähigkeiten aber noch längst nicht in vollem Umfang aus. Das soll sich eines Tages ändern, denn auf Basis von Gemini Live arbeitet man derzeit am Project Astra, mit dem die Nutzung von Gemini auf eine völlig neue Ebene gehoben werden soll – auf eine visuelle Ebene. Passend dazu dürfte es auch wieder Smart Glasses geben.

Auf der großen Bühne der Google I/O wurden vor gut eineinhalb Wochen nicht nur kommende Produkte gezeigt, sondern auch ein Ausblick auf aktuelle Entwicklungen und deren zukünftige Möglichkeiten gegeben. Die ohne Frage beeindruckendste Demo war sicherlich das Project Astra. Dabei handelt es sich um die Nutzung von Gemini Live in Kombination mit der Auswertung des Kamerabildes – und das Live. Viel besser kann man die mediale Komponente von Gemini woh nicht mehr integrieren.

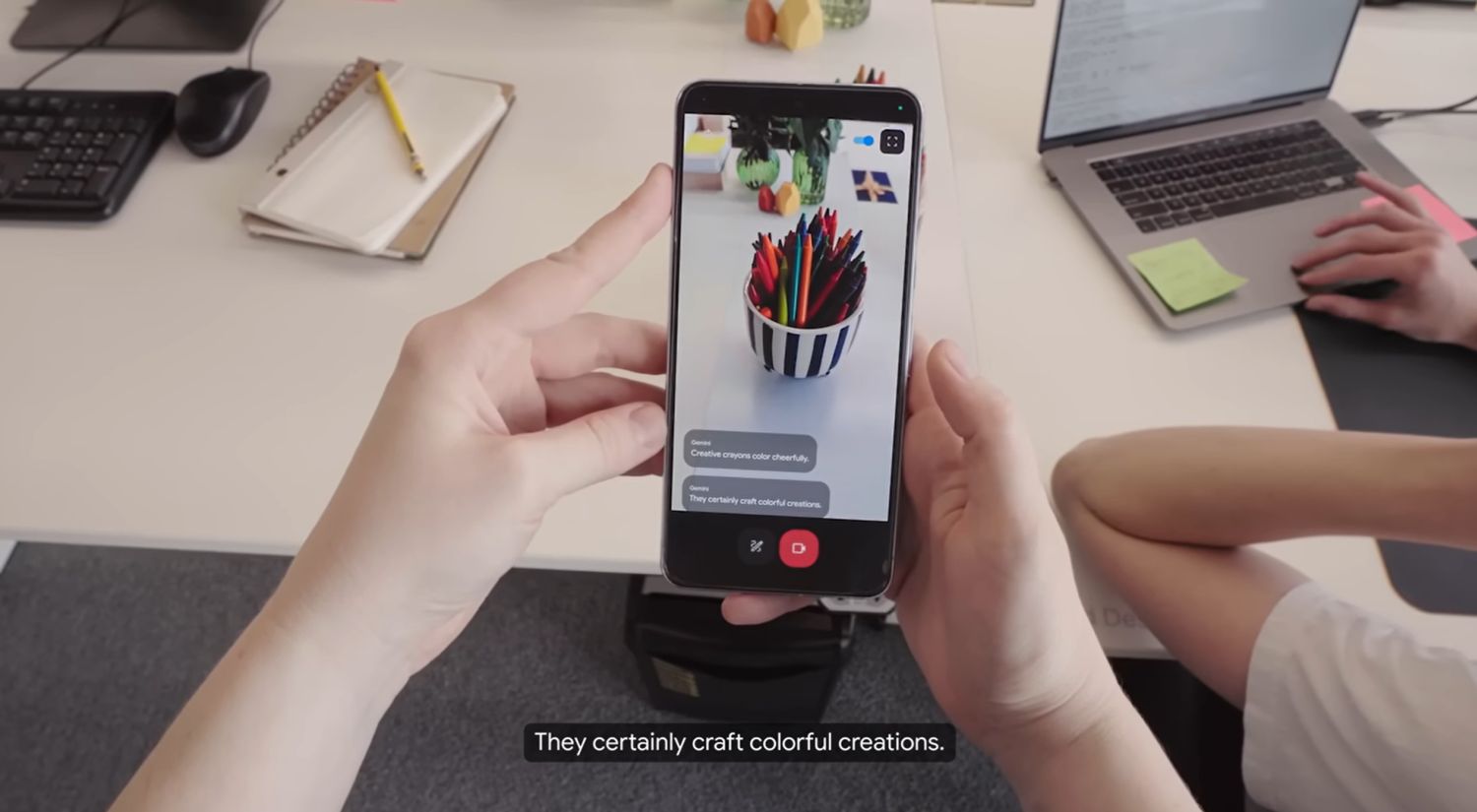

Wenn das Produkt hinter dem aktuell noch in einer frühen Phase befindlichen Projekt verfügbar ist, werden die Nutzer die Möglichkeit haben, ihre Kamera auf beliebige Dinge zu richten und sich über den aktuellen Bildausschnitt mit Gemini zu unterhalten. Einen kleinen Eindruck davon kann man vielleicht schon bald mit der ebenfalls angekündigten Video-Auswertung in der Google-Gemini-Websuche erhalten, aber dieses Tool geht zumindest im unten eingebundenen Demo-Video, das man in voller Länge auf der Bühne gezeigt hat, noch einen deutlichen Schritt weiter.

Denn Gemini kann nicht nur Objekte und Szenerien in einm fertigen Video erkennen, sondern diese auch im Livebild erkennen und als Eingabe verwenden. So lassen sich Dinge beschreiben, Aufgaben lösen, auch komplexe Zeichnungen mehr oder weniger Live erkennen und verbessern. All das bezieht sich per Gemini Live aufeinander, sodass auch Fragen zu vorher sichtbaren Dingen gestellt werden können oder die KI die gesamte Szenerie versteht und miteinander kombiniert.

Der Clou im Video kommt bei Minute 1:25, sowohl funktionell als auch in puncto kommender Geräte. Denn der Nutzer fragt Gemini, wo er denn wohl seine Brille abgelegt hätte , die zuvor nur ganz kurz im Video zu sehen war. Überraschung: Gemini hat sich nicht nur die Existenz der Brille gemerkt, sondern auch deren Position. So ist das KI-Modell in der Lage, die Position der Brille genau beschreiben. Das bedeutet, dass Gemini eine Form der Aufzeichnung des Livebilds durchführt oder tatsächlich alle sichtbaren Objekte und deren Verbindung oder Verhältnis zueinander registriert und für die Dauer der Live-Konversation im digitalen KI-Hinterkopf behält.

Die zweite große Überraschung kommt, als der Nutzer seine Brille gefunden hat. Denn dabei handelt es sich nicht um eine normale Brille, sondern um neue Smart Glasses. Eigentlich hatte man die Entwicklung der smarten Brillen erst vor wenigen Monaten vollständig eingestellt, aber das scheint wohl nur für den AR-Bereich zu gelten. Denn jetzt ist ein solches Modell plötzlich wieder im Video zu sehen und zumindest für diese Aufnahme hat man recht offensichtlich das zuvor als „Pixel Glass“ bekannte Produkt genutzt. Die ganze Demo erinnert ein wenig an die Google Glass-Thema vor 12 Jahren, ist aber heute deutlich realistischer als damals. Es sieht also ganz nach einer Rückkehr der Google Smart Glasse aus.

Das Projekt soll sich noch in einem frühen Stadium befinden und man hat bisher nicht verraten, wann mit einer ersten Verfügbarkeit zu rechnen ist. Man spricht gar von „unsere Vision“, sodass sich schwer sagen lässt, ob das in der Form heute überhaupt schon möglich ist.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter