Gemini: Spektakuläre KI-Demo – Googles Project Astra analysiert Livebild und bringt Smart Glasses (Video)

Google will Gemini aus seinen ChatBot-Fesseln befreien und dessen multimodale Fähigkeiten schon bald in deutlich größerem Umfang nutzen. Dafür hat man parallel zum neuen Format Gemini Live das neue Project Astra angekündigt, das die Nutzung von Gemini auf eine völlig neue, visuelle, Ebene hebt. Und ganz nebenbei zeigt man schon wieder neue Smart Glasses.

Schon einen Tag vor der Google I/O wurde ein beeindruckender Gemini-Teaser veröffentlicht und auf der großen Bühne hat man das Ganze offiziell angekündigt oder zumindest in Aussicht gestellt: Gemini wird das Kamerabild des Smartphones Live auswerten und zu diesem Fragen beantworten können. Das kommende Feature basiert auf dem ebenfalls angekündigten Gemini Live und fügt diesem die wichtige mediale Komponente hinzu.

Wenn das Produkt hinter dem aktuell noch in einer frühen Phase befindlichen „Project Astra“ verfügbar ist, werden die Nutzer die Möglichkeit haben, ihre Kamera auf beliebige Dinge zu richten und sich über den aktuellen Bildausschnitt mit Gemini zu unterhalten. Einen kleinen Eindruck davon kann man vielleicht mit dem neuen Google TalkBack mit Gemini-Unterstützung erhalten, aber dieses Tool geht zumindest im unten eingebundenen Demo-Video, das man in voller Länge auf der Bühne gezeigt hat, noch einen deutlichen Schritt weiter.

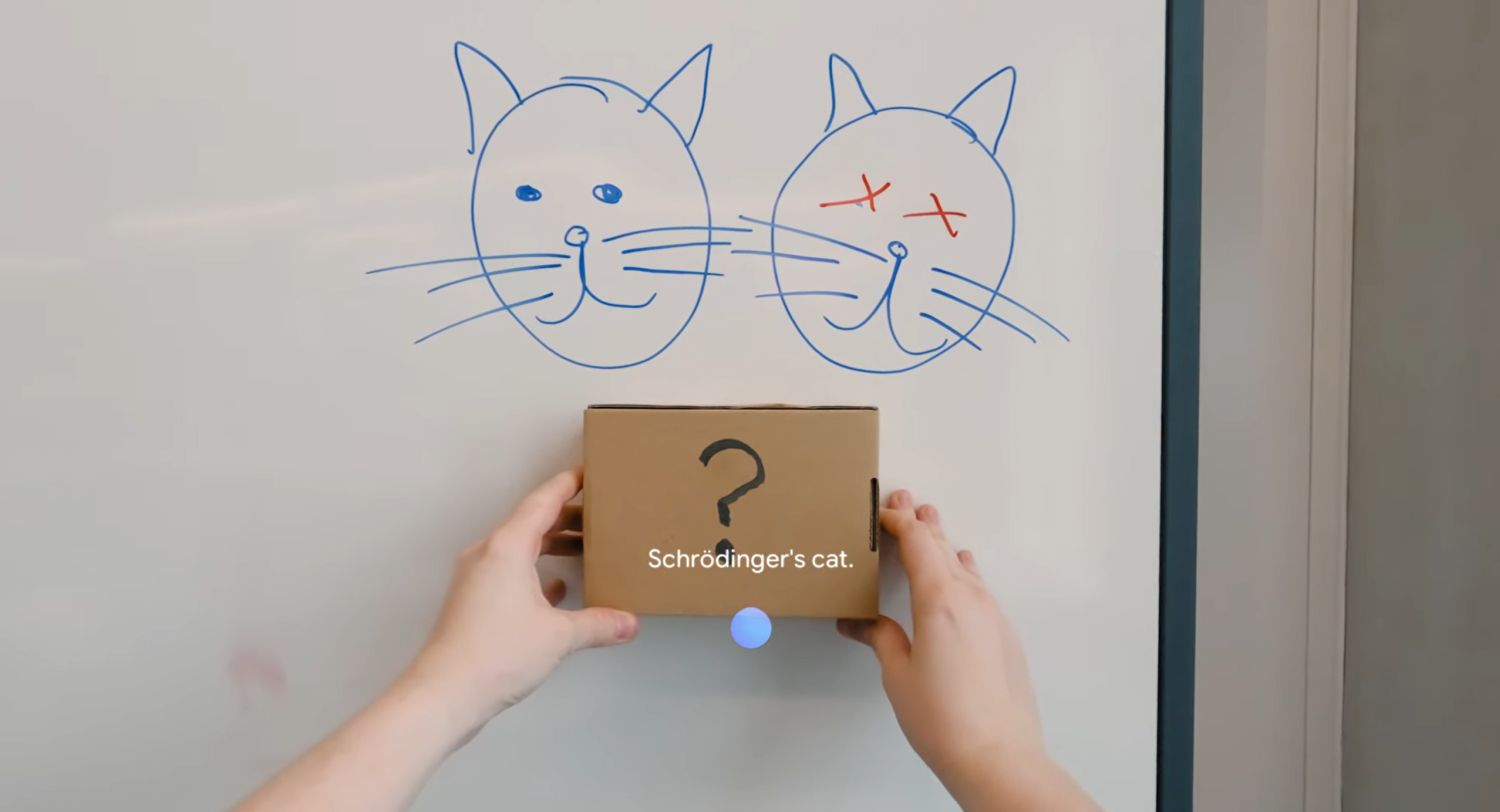

Denn Gemini kann nicht nur Objekte und Szenerien erkennen, sondern diese auch als Eingabe verwenden. So lassen sich Dinge beschreiben, Aufgaben lösen, auch komplexe Zeichnungen mehr oder weniger Live erkennen und verbessern. All das bezieht sich per Gemini Live aufeinander, sodass auch Fragen zu vorher sichtbaren Dingen gestellt werden können oder die KI die gesamte Szenerie versteht und miteinander kombiniert.

Der Clou im Video kommt aber bei Minute 1:25. Denn der Nutzer fragt Gemini, wo er denn wohl seine Brille abgelegt hat, die zuvor im Video ganz kurz zu sehen war. Überraschung: Gemini hat es sich gemerkt und konnte die Position der Brille genau beschreiben. Das bedeutet, dass Gemini eine Form der Aufzeichnung des Livebilds durchführt oder tatsächlich alle sichtbaren Objekte und deren Verbindung zueinander registriert und für die Dauer der Live-Konversation im digitalen KI-Hinterkopf behält.

Die zweite große Überraschung kommt, als der Nutzer seine Brille gefunden hat. Denn dabei handelt es sich tatsächlich wieder um eine neue Version von Pixel Glass, das man eigentlich erst vor wenigen Monaten vollständig eingestellt hat. Es wurden jegliche Arbeiten an den Smart Glasses eingestellt und jetzt sind sie plötzlich im Video zu sehen – auch im Einsatz in Kombination mit Gemini Live. Das erinnert ein wenig an die Google Glass-Thema vor 12 Jahren, ist aber heute deutlich realistischer als damals.

Das Projekt soll sich noch in einem frühen Stadium befinden und man hat bisher nicht verraten, wann mit einer ersten Verfügbarkeit zu rechnen ist. Man spricht gar von „unsere Vision“, sodass sich schwer sagen lässt, ob das in der Form heute überhaupt schon möglich ist. Es wird wohl noch etwas länger dauern.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter