Googles unberechenbare Algorithmen: Das Auf und Ab der Zahlen am Beispiel des GoogleWatchBlog

Google ist für den überwiegenden Teil der Besucherströme im Internet verantwortlich und bis auf ganz ganz wenige Ausnahmen die größte Trafficquelle für redaktionell gepflegte Webseiten. Das schafft eine solch extreme Abhängigkeit, dass eine Google-Abstrafung sehr schmerzhaft werden kann, doch das Unternehmen macht es Webmastern auch nicht leicht. Heute möchte ich ein neues Beispiel anführen, warum Google so unberechenbar ist.

GoogleWatchBlog hat große Probleme und benötigt eure Unterstützung, aber ein mögliches Ende kann auch immer eine Chance auf einen Neuanfang sein und so widmen wir uns hier in jüngster Zeit auch den Problemen, die man als Webmaster mit Google haben kann und stellen das recht transparent dar. Ich hatte schon vor einigen Tagen über die Fehleranfälligkeit der AdSense-Algorithmen berichtet und heute geht es mit dem Herzstück weiter: Der Google Search Console.

Die Google Search Console ist die wichtigste Anlaufstelle für Webmaster, um ihre Präsenz in den Google-Produkten zu kontrollieren und mögliche Fehler aufzuspüren. Das wäre eigentlich eine feine Sache, aber leider ist man den Algorithmen und ihren Entscheidungen hilflos ausgeliefert und so kann man sich so manchen Blick auf die Statistiken und Fehler auch gleich ersparen – denn es gleicht einem Glücksspiel, ob man gut oder schlecht darsteht.

Im Folgenden seht ihr einige Statistiken und Diagramme aus dem Search Console-Konto von googlewatchblog.de. Das soll nur beispielhaft zeigen, wie willkürlich die Algorithmen entscheiden. Das dürfte bei jedem Webmaster anders aussehen, aber grundlegend hat wohl jeder die gleichen Probleme. Ich schreibe hier nur über meine persönlichen Erfahrungen.

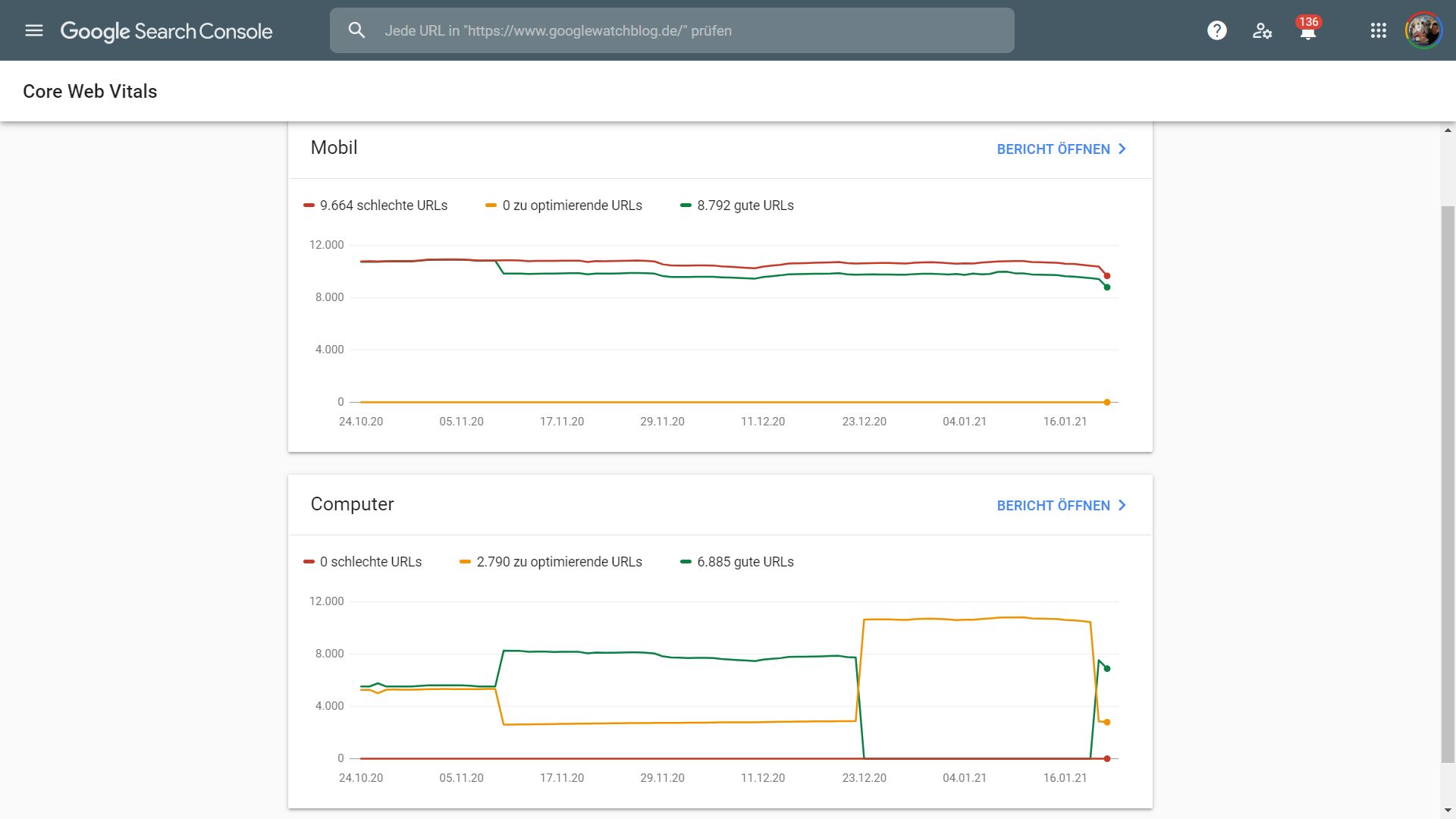

Core Web Vitals

Die Core Web Vitals geben über die allgemein Performance der Webseite Auskunft und werden (oder sind?) laut Google ein wichtiges Rankingsignal. Man sollte also darauf achten, in dieser Statistik gut abzuschneiden – aber wie? Was soll man mit obiger Statistik anfangen, die völlig wahllos scheint? Natürlich wurde hier am Blog nichts geändert, weder auf der Webseite noch im Hintergrund an den Servern. Dazu muss man auch bedenken, dass es hier im Blog ja eigentlich nur zwei Seitentypen gibt: Artikel und die Startseite. Jeder Artikel ist gleich, unterscheidet sich natürlich vom Inhalt, aber hat einen ähnlichen Aufbau. Warum nun Artikel XY sehr gut und Artikel YZ sehr schlecht ist, ist nicht nachvollziehbar.

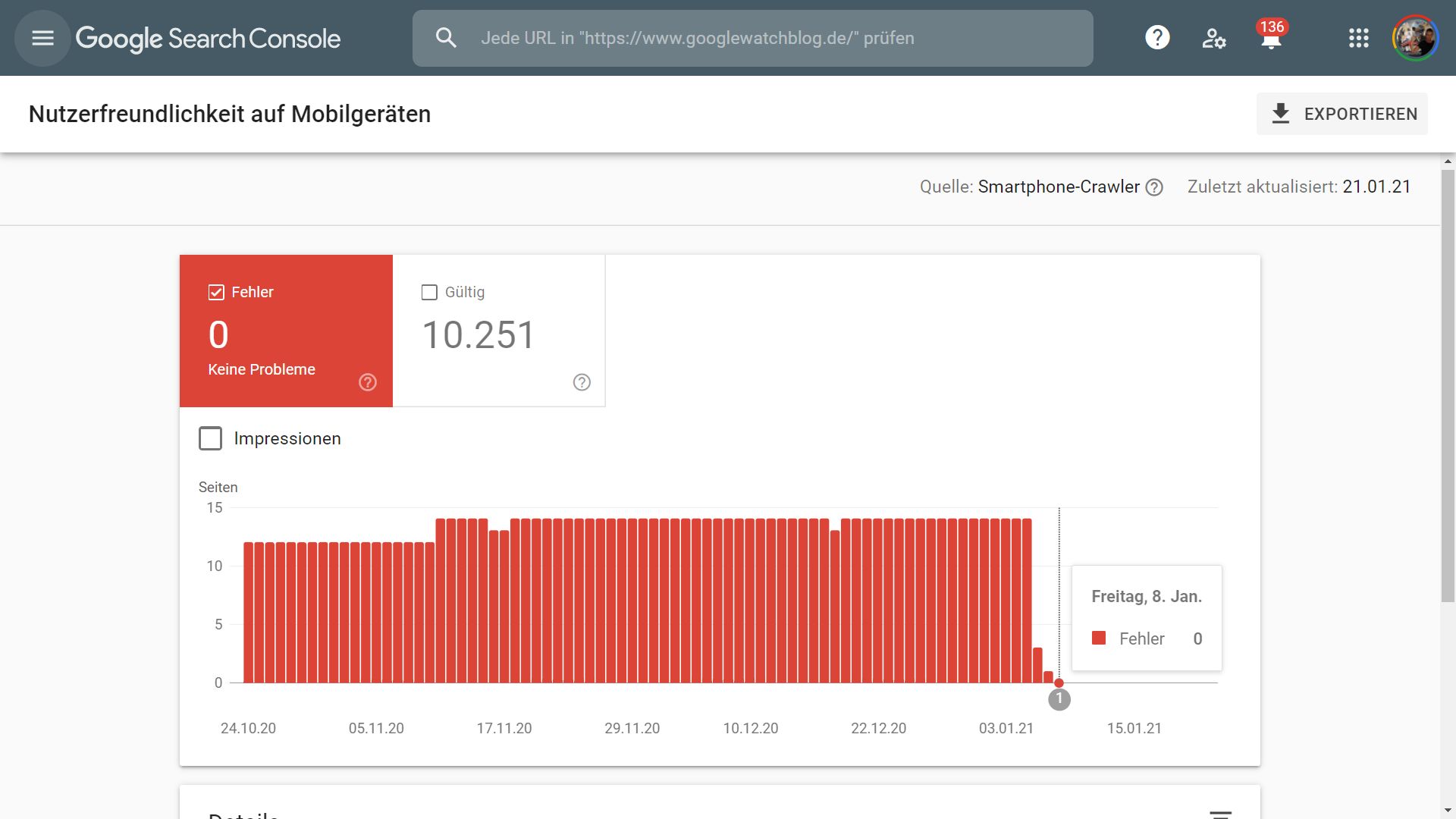

Nutzerfreundlichkeit auf mobilen Geräten

Das mobile Web hat dem Desktopweb längst den Rang abgelaufen, es ist also eine sehr wichtige Statistik. Diese Statistik informiert über Fehler und Probleme auf der mobilen Webseite. Ich hatte hier schon einmal darüber berichtet, dass der GoogleWatchBlog seit Anfang 2020 dauerhaft 14 Fehler aufwies – und zwar jeden Tag andere. Jeden Tag klickte ich auf validieren, die Fehler verschwanden und am nächsten Abend gab es 14 neue. Ein Kreislauf, der für mich zum festen Tagesablauf gehörte: Console öffnen, validieren, fertig. Niemals wurde irgendetwas geändert.

Fun Fact: Seitdem der Blog keinen Discover-Traffic mehr erhält sind die Fehler verschwunden. Von heute auf und morgen und natürlich ohne dass etwas geändert wurde.

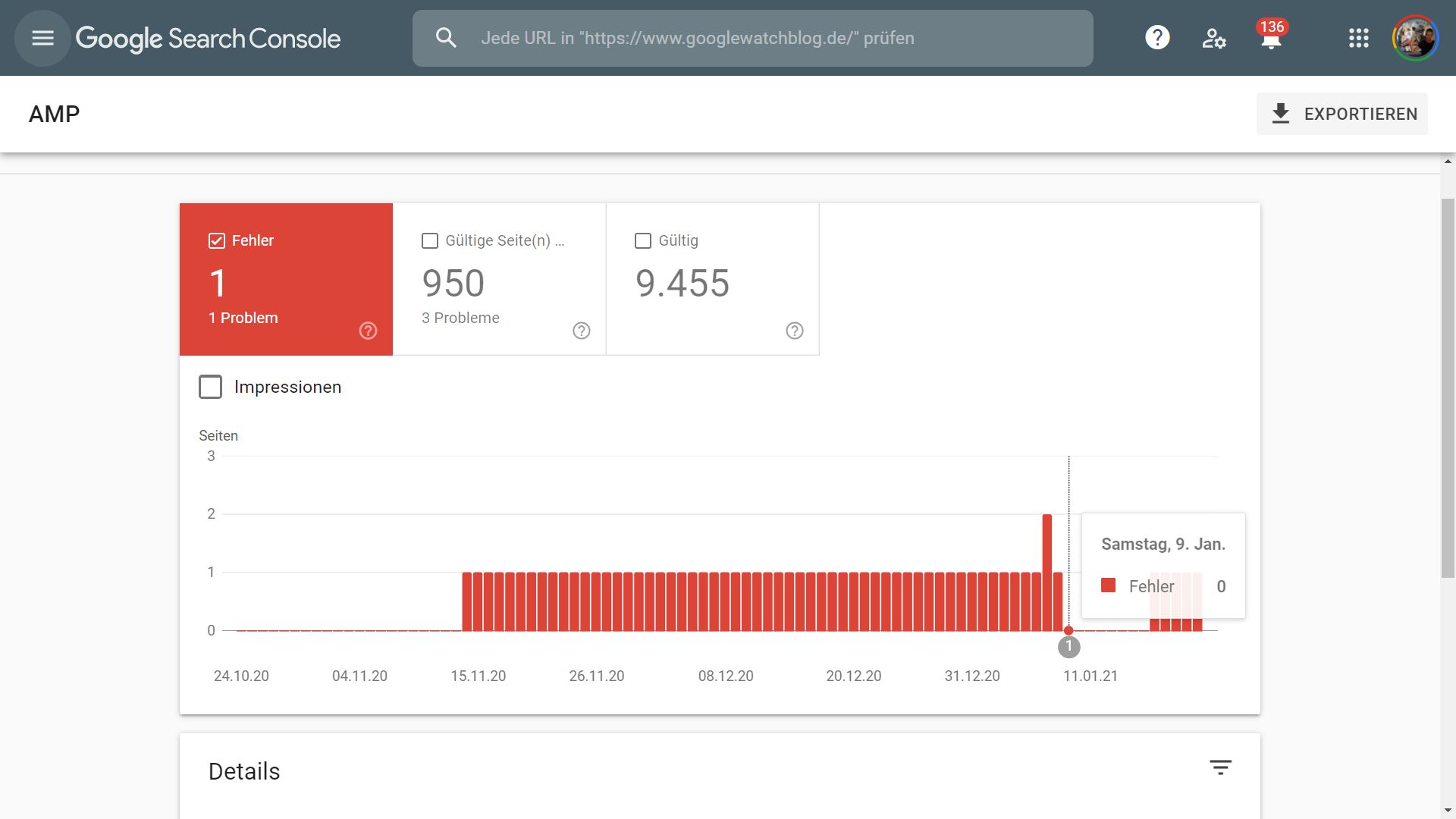

AMP

AMP ist ein sehr wichtiges Format, denn es wird von Google im mobilen Web gepusht und Webseiten im AMP-Format werden besonders hervorgehoben – das bringt Klicks. Fehler auf AMP kann man sich also nicht erlauben. Im GoogleWatchBlog gibt es praktisch dauerhaft 2-3 AMP-Fehler – wie schon bei den Mobilfehlern stets auf wechselnden Seiten. Schickt man eine vor wenigen Minuten angekreidete URL durch Googles eigenen AMP-Validator, weist diese keinen Fehler auf.

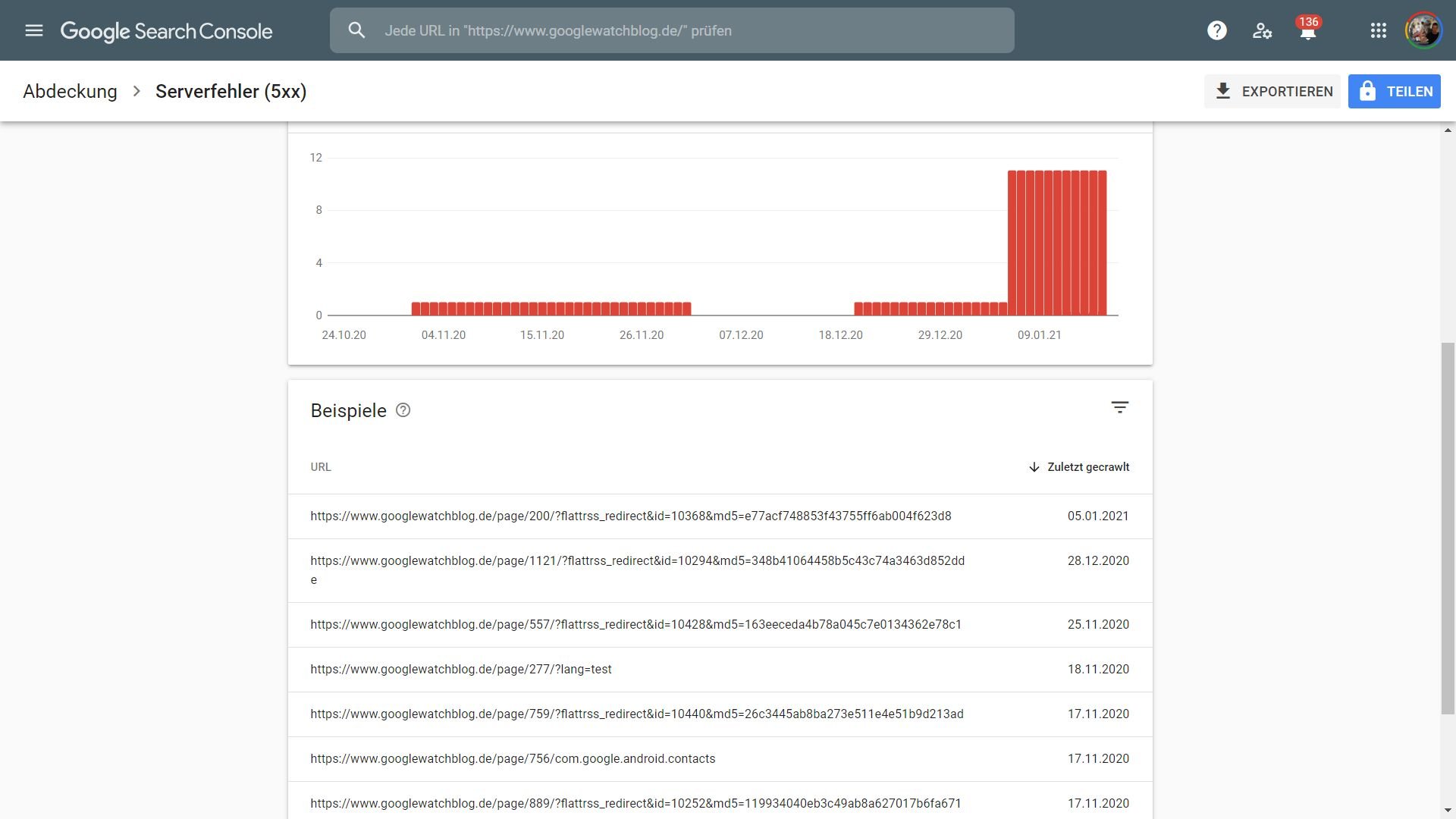

Abdeckung

In dieser Statistik informiert Google über Fehler und Probleme, die beim Crawlen aufgetreten sind. Leider werden hier URLs als Fehler aufgelistet, die von externen Webseiten verlinkt werden und eventuell gar nicht existieren. Das liegt außerhalb der Kontrolle des Webmasters, natürlich kann man das mit eigenen Fehlerseiten und Weiterleitungen abfangen, aber grundsätzlich kann man diese Links meistens nicht loswerden.

Fazit

Was soll man nun als Webmaster tun? Das Ganze einfach ignorieren, weil es ja sowieso nichts bringt? Könnte man tun und sich den Aufwand und die Nerven sparen, aber möchte man wirklich riskieren, die wichtigste Trafficquelle zu verlieren? Vermutlich nicht. Und so bleibt einem eigentlich nur übrig, auf die Zahlen zu blicken, sich zu ärgern und darauf zu hoffen, dass es morgen wieder besser aussieht. Ziemlich frustrierend.

Ich bin lange Zeit sehr entspannt geblieben, aber bei der aktuellen Situation des Blogs sieht das eben ein bisschen anders aus…

P.S. Die Unterstellung der Verbreitung von pornographischem Material im GoogleWatchBlog ist übrigens ohne jegliche Ankündigung und Entschuldigung fallengelassen worden. Genauso wie die AdSense-Sperre im Dezember.

GoogleWatchBlog unterstützen

» PayPal-Spende

» In eigener Sache: GoogleWatchBlog benötigt eure Unterstützung; Vielen Dank an alle Unterstützer!

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Jens, der Blog ist unfassbar schlecht aufgestellt, was die technischen Aspekte angeht, die Google für seine Rankings heute und zukünftig berücksichtigt. Seit einiger Zeit wird Mobile-first indexiert und da überwiegen hier die als schlecht bewerten URLs sogar. Keine einzige URL sollte als schlecht bewertet sein. Auch für den Desktop heutzutage nicht alles auf grün zu haben, sollte dich eigentlich alarmiert haben. Dazu die anderen Fehler, die die Konsole ausspuckt. Außerdem: Deine Pagespeed Experience ist brutal, aber nicht im positiven Sinne.

Du hast unfassbar viel Luft nach oben, hier müssen einige Optimierungen sein. Und da wundert mich auch nicht, dass du so abgestraft wurdest, das war bei der Faktenlage nur die erwartbare Konsequenz.

Die News hier schätze ich wirklich sehr, aber ich kann mich dem nur anschliessen!

Ich wollte beim letzten Bericht auch mal einen Hinweis schreiben, woran es ausser an Google noch liegen könnte (Stichwort Webseiten Reputation von Virenscannern) das ging aber nicht, weil die Kommentarfunktion deaktiviert war.

Also eine andere Kontaktmöglichkeit gesucht, gefunden und geschrieben und dann gab es beim abschicken aber mehrfache Fehler, auch mit anderen Browsern, also hab ich es aufgegeben.

Aus https://de.wikipedia.org/wiki/Accelerated_Mobile_Pages

Der AMP-Anspruch, lediglich Seitenabrufe zu beschleunigen, ist umstritten. Eine Kartellrechtsklage von zehn US-Bundesstaaten offenbarte auf Seite 80 in Absatz 212, dass Google Nicht-AMP-Anzeigen im Vergleich zu AMP-Anzeigen künstlich um eine Sekunde verzögerte: http://www.texasattorneygeneral.gov/sites/default/files/images/admin/2020/Press/20201216%20COMPLAINT_REDACTED.pdf

In Chrome den Lighthouse Report anschauen. Da gibt es sehr viel Optimierungsvorschläge.

Ich mag den Blog sehr und finde die Artikel auch sehr spannend.

Aber hier kann ich mich meinen Vorredner nur anschließen. Da gibt es Luft nach oben und das ist kein Hexenwerk, sondern SEO 😉

Wenn du da Unterstützung brauchst, kann ich dir gerne ein wenig helfen.