Google Lens: Die Augen des Google Assistant sind weit von dem entfernt, was mal versprochen wurde (Video)

Mit Google Lens hat der Google Assisant vor knapp drei Jahren endlich „Augen“ bekommen und eine starke Objekterkennung erhalten, die aber eigentlich sehr viel mehr sein möchte als ein reiner Bildvergleich. Noch vor dem offiziellen Start des Produkts wurden auf der großen Bühne einige Demo-Funktionen gezeigt, die bis heute nicht einmal annähernd möglich sind und vielleicht schon längst wieder verworfen wurden.

Der Google Assistant ist ein recht smartes Produkt, das viele Anfragen der Nutzer in schriftlicher oder verbaler Form erkennen, verarbeiten und häufig zur Zufriedenheit des Nutzers beantworten kann. Doch trotz der Flexibilität ist der Assistent von einer gewissen Intelligenz noch weit entfernt, denn viel mehr als das Herauspicken von Schlüsselwörtern und Ausführen entsprechend vorprogrammierter Funktionen ist in den meisten Fällen nicht drin. Das ist bei Lens ganz ähnlich.

Google Lens kann manchmal ein sehr beeindruckendes Produkt sein: Der Nutzer hält die Smartphone-Kamera auf ein Objekt, ein Foto, ein Lebewesen (kein Mensch) oder einen Text und bekommt dazu passende Informationen ausgespuckt. Das kann die Bezeichnung des Objekts sein, ein darauf geschriebener Text, eine Pflanzensorte, Tierrasse, CD-Cover oder vieles mehr von Bauwerken bis Sehenswürdigkeiten. Doch so praktisch das für den Nutzer auch ist, ist es „nur“ ein Mustervergleich.

Natürlich steckt hinter Google Lens eine große Maschinerie mit einer riesigen Datenbank zur Zuordnung aller Objekte, aber darüber hinaus ist in den letzten Jahren nicht mehr viel passiert. Aktuell kann man Lens eher mit der Objekterkennung in Google Fotos als dem Produkt vergleichen, das vor knapp drei Jahren versprochen wurde. Vor wenigen Tagen wurde bekannt, dass Google Lens Mathematik-Aufgaben lösen kann, was endlich in die Richtung geht, die damals gezeigt wurde. Aber es ist eben auch nur ein Teilbereich.

Eine sehr viel einfachere Form der Objekterkennung gibt es beispielsweise bei Google Translate, das Texte Live im Kamerabild übersetzen kann. Das beeindruckt immer wieder, ist aber grundsätzlich mit der starken Bilderkennung von Lens, Fotos und einigen anderen Produkten keine große Hexerei mehr. Schauen wir uns aber nun einmal an, was Google damals versprochen hat.

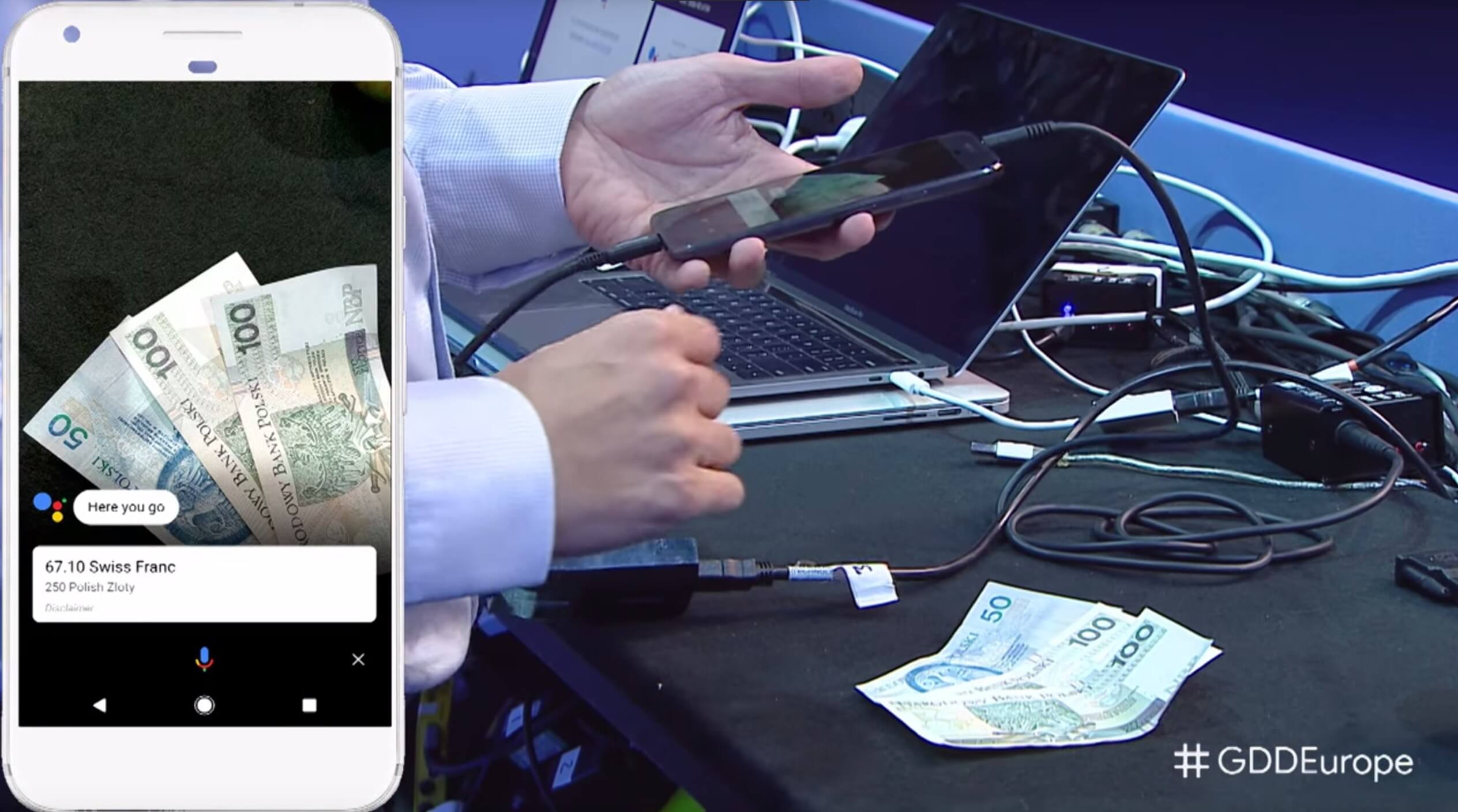

Im Herbst 2017 hat Google auf der großen Bühne gezeigt, was mit Google Lens möglich sein soll – wobei man als interessierter Zuschauer natürlich davon ausgeht, dass das in absehbarer Zukunft der Fall sein wird. Das ist nun aber schon weit über zweieinhalb Jahre her und bis heute sind wir noch nicht einmal in die Nähe dessen gekommen, was damals in der Live-Demo gezeigt worden ist. Wir können also davon ausgehen, dass es keine echte Demo, sondern nur ein zuvor programmierter Ablauf gewesen ist.

Unter Erstaunen der Zuschauer im Saal und im Livestream wurde gezeigt, wie ein Bündel Geldscheine mit Google Lens abfotografiert wurde. Direkt darauf konnte das Smartphone den Wert in einer beliebigen Währung ausspucken, was im Hintergrund tatsächlich eine kleine Meisterleistung erfordert: Zuerst muss jeder einzelne Geldschein erkannt werden, obwohl diese im typischen gefächerten Zustand nicht vollständig sichtbar sind. Dann muss aus diesen erkannten Objekten der Wert und die Währung sowie die Tatsache, dass es sich um ein Zahlungsmittel handelt, extrahiert werden. Das ist dann auch schon die ganze Aufgabe von Lens.

Das Umrechnen in eine andere Währung ist ein Kinderspiel und steht etwa in der Google Websuche seit vielen Jahren zur Verfügung. Google Lens hat aber schon beim ersten Schritt große Probleme und wäre höchstens dazu in der Lage, den ersten, vollständig sichtbaren, Geldschein zu erkennen. Natürlich ist das ein Szenario, das man nicht täglich benötigt, aber es sollte zeigen, wo die Reise mit Lens hingehen soll. Ein ähnlich smartes Feature hat es bisher aber nicht gegeben. Schaut euch einfach das folgende Video ab Minute 52 an.

In einer weiteren Demo zu sehen, wie ein Apfel vor die Kamera gehalten wird und sofort der Kaloriengehalt ausgespuckt wird. Die Anzeige von Kalorien zu vielen Lebensmitteln ist ebenfalls seit langer Zeit über die Websuche möglich, aber bei der Erkennung des Apfels wird es dann schon schwer. Dass es ein Apfel ist, bekommt Lens in den allermeisten Fällen noch hin. Um welche Sorte es sich handelt und wie groß der Apfel ist, damit der Kaloriengehalt zumindest annähernd angegeben werden kann, weiß Lens hingegen nicht.

Wäre so etwas tatsächlich möglich, könnte man eines Tages auch im Restaurant die Pizza mit ihren gut sichtbaren Belag scannen und sofort wissen, wie viel Kalorien man sich damit in etwa zumuten würde. Niemand erwartet exakte Werte, das ist wohl auch unmöglich, aber Google Lens ist noch nicht einmal in der Nähe eines solchen Funktionsumfangs. Fraglich, ob das überhaupt jemals funktionieren wird.

Niemand erwartet von Google Lens Wunder, aber wenn man solche Dinge auf der großen Bühne zeigt, dann sollten sie auch Substanz haben und nicht dafür sorgen, dass die Nutzer am Ende enttäuscht sind. Diese Demo ist aber vergleichbar mit der ebenfalls im Jahr 2017 getätigten Ankündigung, dass Google Fotos bald Objekte aus Bildern entfernen kann – was bis heute nicht möglich ist. Oder man denke an die Produktpräsentation von Google Glass, von der auch acht Jahre später noch nicht alles realisierbar ist.

Das Erkennen und Lösen von Mathematik-Aufgaben geht endlich in die richtige Richtung und würde erstmals nicht nur das Objekt erkennen, sondern tatsächlich etwas damit anfangen können. Und dann muss man fairerweise dazu sagen, dass ausgerechnet diese Technologie im vergangenen Jahr von Google eingekauft und nicht vom Lens-Team selbst entwickelt wurde. Und wer sich noch an Google Goggles erinnert, wird wissen, dass diese App schon vor zehn Jahren Sudokus lösen konnte. Das kann Lens bis heute nicht.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Vor rund 3 Jahren habe ich angefangen Google richtig nice zu finden und konnte über kleine „Das kommt noch“ Situationen hinwegsehen. Ich würde nicht von mir behaupten, alles von Google zu kennen und zu haben, aber ich habe mir einiges in der Zeit zugelegt und täglich genutzt. Seit ca. 6 – 9 Monaten muss ich feststellen, dass Google groß darin ist vollmundige Versprechen zu machen, die sie bis heute weder einhalten oder mit einer signifikanten Verspätung raus bringen und dann nicht mal so wie versprochen.

Ich weiß z.B. nicht wie man 6 Monate nach Ankündigung erst die Pixel Buds 2 rausbringen kann. Wenn es noch nicht so weit ist, dann warte ich doch noch und bringe sie quasi am Tag der Vorstellung raus.

Das Pixel 4 ist eine brutale Enttäuschung und hat mich dazu gebracht meinen Vertrag nicht zu verlängern mit einem neuen Handy, sondern ihn zu kündigen.

Google Pixel Buds haben mir zu lange gedauert, sodass ich auf eine Alternative ausweichen musste.

Stadia nutze ich seit Tag 1 und auch wenn ich mit der Performance und der Spieleauswahl ehrlichzufrieden bin, haben mich Features wie der eingebaute Assistant in Spielen erst zu den Kauf bewegt. Man kann ihn heute nicht mal benutzen. Und wieso sollte ich die Assitanttaste drücken und eine Spracheingabe machen um ein Spiel zu starten, wenn ich nur 1 x „A“ drücken muss. Das ist alles nur augenwischerei.

Diese ganzen Versprechen und dicken Ankündigungen aus die nichts wird oder nur die Hälfte bei rum kommt (und zwar oft die uninteressantere Hälfte), bewegen mich dazu zur Konkurrenz zu gehen, denn die bringen zeitnah das raus was sie ankündigen und kündigen oftmals nur das an was sie auch einhalten können.