Beeindruckend: Google zeigt erstmals die neuen Möglichkeiten von Google Lens & Assistant [Video]

Schon vor gut vier Monaten hat Google erstmalig die neue Plattform Lens vorgestellt, hat sich aber seitdem nicht mehr öffentlich zu den „Augen des Assistant“ geäußert. Auf einer Entwickler-Konferenz in Polen hat Google nun erstmals Lens in Aktion und dessen beeindruckende Funktionen gezeigt. Außerdem waren auch neue Feature des Google Assistant selbst zu sehen, die vermutlich schon bald ausgerollt werden.

Mit dem Google Assistant hat Google innerhalb kürzester Zeit einen Assistenten hochgezogen, der alle Fragen des Nutzers beantworten und viele Aufgaben übernehmen kann. Dieser profitiert natürlich sehr stark von den jahrelangen Erfahrungen und den Grundlagen der Websuche, und ist damit vom Start weg an der Konkurrenz vorbeigezogen. In diesem Jahr soll Lens nun das gleiche Kunststück gelingen, das die Erkennung von Informationen auf eine völlig neue Stufe hebt.

Im Mai hatte Google Lens als neue Plattform vorgestellt, mit der man die intelligente Erkennung von Bildern bzw. Fotos der Kamera bündeln und auf eine neue Stufe heben möchte, doch bisher konnte man sich darunter nicht viel vorstellen. Auf den Google Developer Days in Polen hat man Lens nun erstmals tatsächlich in Aktion gezeigt, und weiß damit durchaus zu begeistern. Es handelt sich dabei nicht nur um eine Bilderkennung, sondern um eine ganze Reihe von verknüpften Funktionen um dem Nutzer die Informationen zu liefern.

In obigem Video ist (ab Minute 52) die Präsentation von Lens zu sehen. Als erstes richtet der Präsentator einfach die Kamera auf einen Apfel, und fragt den Assistenten nach dem Kaloriengehalt. Innerhalb von einer Sekunde antwortet der Assistent dann mit dem durchschnittlichen Kaloriengehalt eines mittleren Apfels. So einfach das aussieht, so schwer ist das im Hintergrund. Der Nutzer hat nicht gezielt nach dem Apfel gefragt, sondern nur „es“. Die Algorithmen müssen also erst einmal das Bild nach einem Lebensmittel durchsuchen und dieses dann auch noch erkennen.

Die Algorithmen erkennen also das es ein Apfel ist, dann auch noch die Größe des Apfels „Medium“ und dann muss man noch einmal sicherstellen, ob es nicht doch noch andere Lebensmittel gibt. Die Abfrage des Kaloriengehalts ist dann keine Kunst mehr.

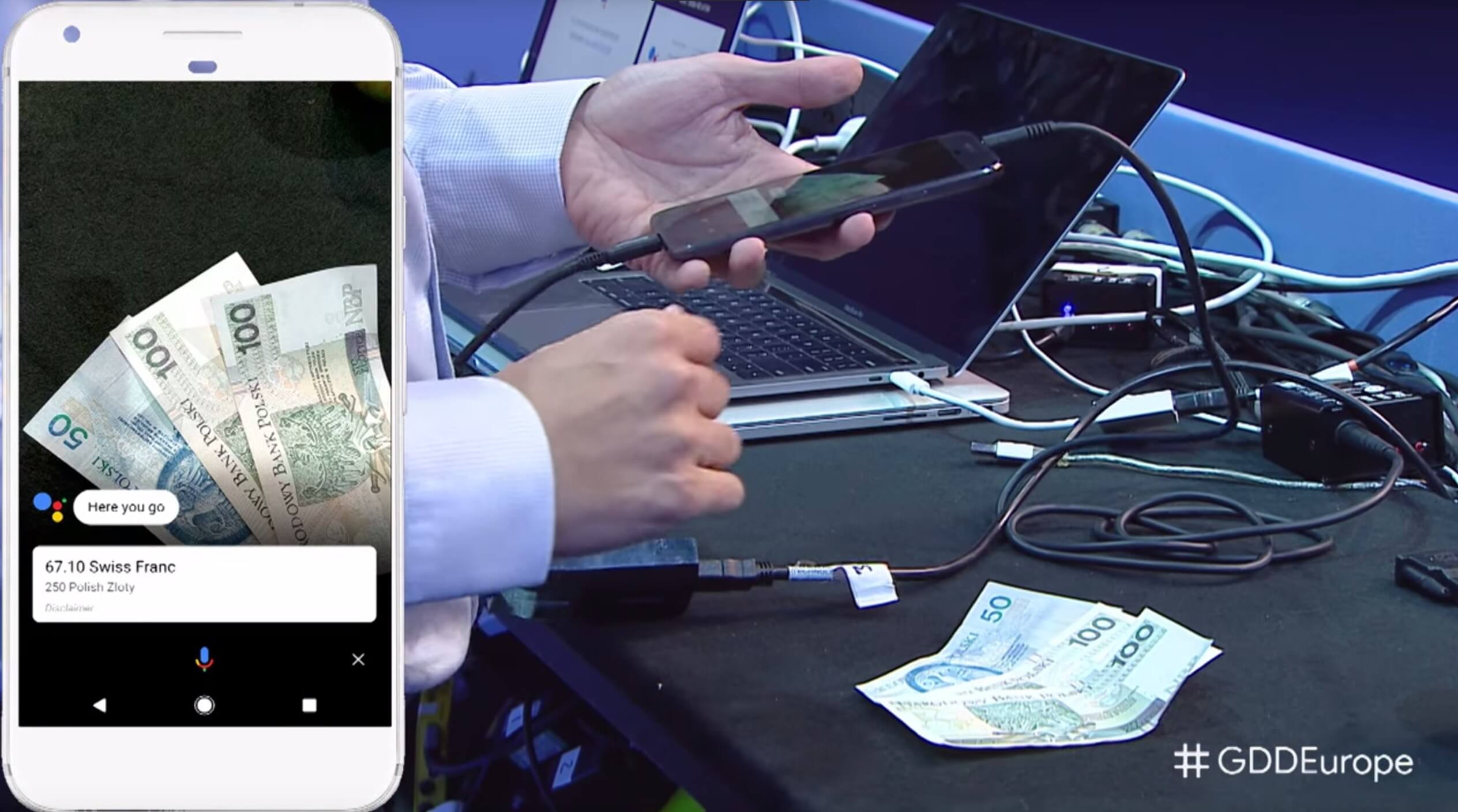

Wen dieses erste Beispiel nun beeindruckt hat, der wird vom zweiten fast schon weggehauen: Der Präsentator legt drei aufgefächerte Geldscheine auf den Tisch, richtet sein Smartphone darauf und fragt den Assistenten wie viele Schweizer Franken das wären. Nach nur einer Sekunde antwortet der Assistent mit dem korrekten Wert und dem zugrunde liegenden Wechselkurs. Im Hintergrund sind dabei sehr viele Schritte vollautomatisch passiert.

Da der Nutzer nach einer Währungsumrechnung gefragt hat, wissen die Algorithmen dass sie nach Geldscheinen oder Münzen suchen müssen. Sind diese dann erkannt, müssen die Algorithmen erkennen um welche Währung es sich überhaupt handelt – was bei den weltweit meist sehr ähnlichen Scheinen schon einmal eine kleine Herausforderung ist. Anschließend müssen alle Scheine als einzelne Objekte erkannt und dann noch deren genauer Wert ermittelt werden. Dieser muss dann zusammengerechnet und dann durch den Umrechner gejagt werden.

Nicht nur die Schritte zur Erkennung sind beeindruckend, sondern natürlich auch die Intelligenz dahinter, die all diese Schritte mit den Zwischenschritten plant und ausführt. Ob es sich bei den beiden Beispielen nun um einprogrammierte Sequenzen oder um eine tatsächliche Intelligenz handelt lässt sich schwer sagen, aber mich hat das Beispiel schon sehr stark beeindruckt.

Google Assistant

Aber nicht nur Lens wurde gezeigt, sondern auch neue Funktionen des Assistant. Dabei drehte sich alles vor allem um den Kontext. So wurde gezeigt, dass man bei der Anfrage nach „Show me pictures of Thomas“ jetzt keine Bilder mehr von zufälligen Personen oder einer Spielzeuglokomotive, sondern eben von Thomas Müller bekommt – einfach aus dem Grund, weil der Nutzer sich in der Vergangenheit für den FC Bayern und auch einmal für Thomas Müller interessiert hat.

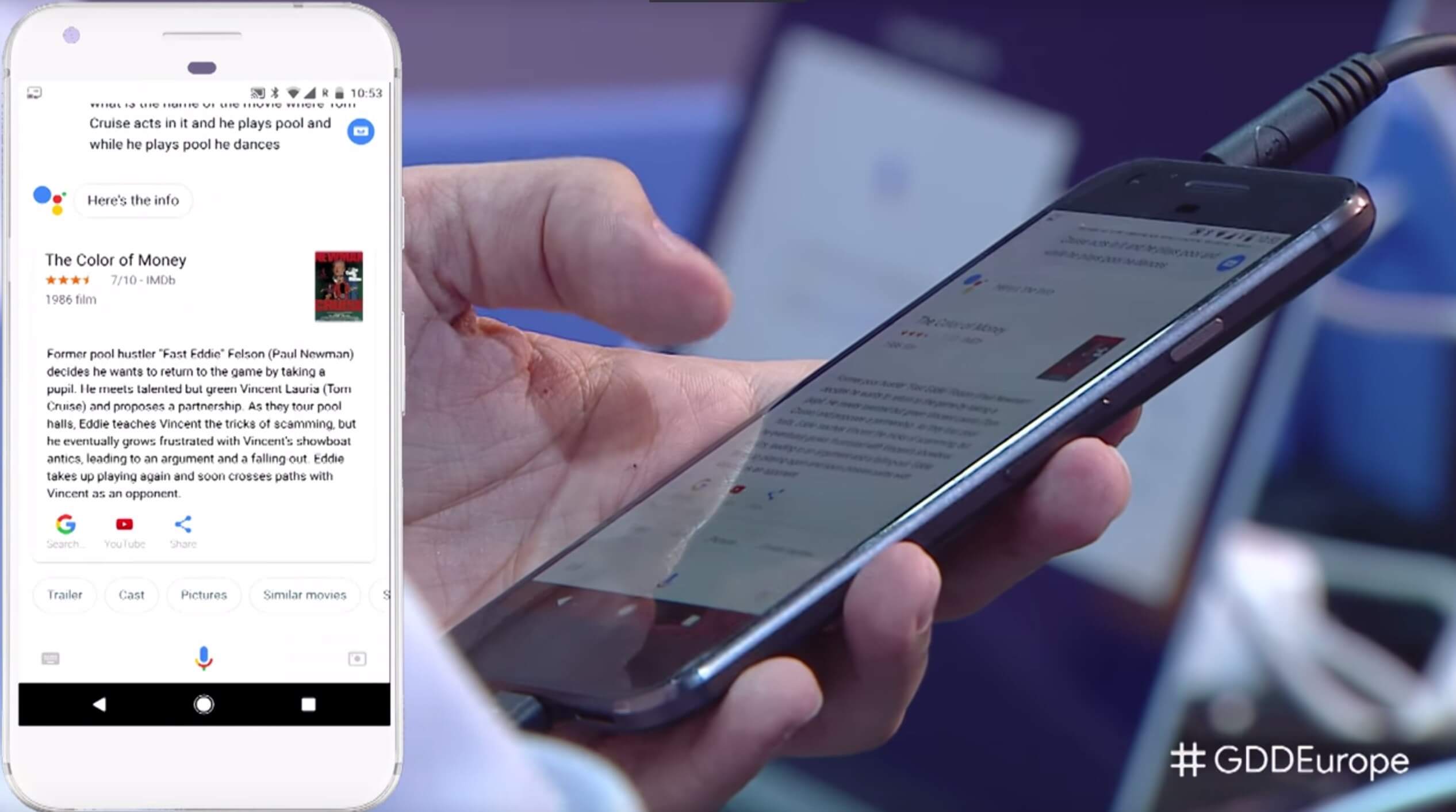

Auch eine Frage nach einem Film wurde sehr merkwürdig gestellt, und konnte von Google dennoch beantwortet werden: So wurde nach einem Film mit Tom Cruise gefragt in dem er gleichzeitig Billiard spielt und tanzt – und tatsächlich wusste der Assistent die richtige Antwort. Das war womöglich Glückssache wegen der Filmbeschreibung, aber das macht es nicht weniger beeindruckend.

—

Sowohl der „neue“ Assistant als auch Google Lens dürften wohl endgültig am 5. Oktober vorgestellt werden. Für Lens wird erwartet, dass es wieder für einige Monate exklusiv auf den Pixel-Smartphones bleiben wird – aber das ist noch nicht endgültig. Auf jeden Fall ist Lens damit der damaligen hauseigenen Konkurrenz Google Goggles deutlich überlegen.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

In Vorführungen mag der Assistant ja ganz nett sein, im Alltag ist er (und sein Vorgänger) jedoch nicht zu gebrauchen.

Beispiele: Da Google Maps nur ein Zuhause (und einen Arbeitsplatz) unterstützt, muss man die Orte anders abspeichern. Mein Zweitwohnsitz zB hat den Namen „Zuhause 2“ bekommen. Trotzdem erinnert mich Google jedes Mal daran, wo ich mein Auto geparkt habe (auch wenn es direkt vor dem Haus steht) – oft auch Stunden später, wenn ich längst wo anders hingefahren bin. Die verspätete Parkplatzerinnerung ist auch an anderen Orten ein grundsätzliches Problem. Fahrzeit zur Arbeit und nach Hause oder aktueller Verkehr am Pendelweg, wenn ich längst unterwegs bin. Auf mögliche Verspätungen wird nicht vorab aktiv hingewiesen – wieso? Im Umkreis meiner Wohnungen und Arbeitsstätte befinden sich viele „Orte“.. wenn ich abends vor dem Fernseher sitze, werde ich gefragt, ob ich gerade dort (1km entfernt) esse und ob ich den Laden nicht bewerten möchte – usw. ernsthaft?

Nicht weit weg von meiner Arbeit ist ein Einkaufszentrum. Wieso muss ich in jeder Mittagspause die Indoor Karte wegwischen? Abundzu kommt die Karte auch erst eine Stunde danach. Mit dem GPS meines Smartphones ist übrigens alles in Ordnung… Das Problem zieht sich mittlerweile über 3 Geräte…

Ein guter Assistant kontaktiert den Anwender aktiv. Das Telefon klingelt schließlich auch, wenn jemand anruft. Wenn ich in der Arbeit sitze und gewöhnlich in einer halben Stunde Feierabend mache – auf meiner Hauptstrecke jedoch ein kilometerlanger Stau ist, dann möchte ich von meinem Handy rechtzeitig darüber informiert werden. Ja, dafür gibt es Apps aber ich denke, der Assistant sollte das können.

Wenn ich im Kalender Urlaub stehen habe und mein Wecker aus ist, dann möchte ich nicht um 10 Uhr lesen, wie lange ich in die Arbeit brauche. usw…

und jetzt hab ich wichtigeres zu tun 😉