So funktioniert die Live-Übersetzung von Bildern & Videos in Google Translate

Schon seit Anfang des Jahres kann Google Translate Text in Bildern live übersetzen, unter anderem auch in Deutsch, doch erst mit dem gestrigen Update wurde der Umfang der Sprachen noch einmal deutlich erweitert und die Geschwindigkeit und Genauigkeit der Übersetzungen erhöht. Diese Live-Übersetzung ist zwar nur eine Kombination aus verschiedenen bekannten Technologien, doch das Endprodukt ist sehr beeindruckend. Jetzt geben die Entwickler einen kleinen Einblick in die Funktionsweise der App.

Für die beeindruckende Live-Übersetzung von Wörtern und Sätzen auf dem Smartphone haben sich die Google-Entwickler in diesem Fall ins gemachte Nest gesetzt: Im Mai vergangenen Jahres hat man das Unternehmen WordLens übernommen, das diese Technologie als eigenständige App angeboten hat – und wenige Monat später war die Funktion in die Translate-App integriert. Der Nutzer muss dabei nur die Kamera auf den gewünschten Text halten und schon wird dieser Live übersetzt und in der gleichen Weise und im gleichen Stilwie das Original im Bild wieder dargestellt.

1. Buchstaben und Zeichen finden

Als erstes müssen natürlich Buchstaben und Zeichen in dem Foto bzw. Livebild gefunden werden. Dazu sucht ein Algorithmus erst einmal nach Gegenständen im Hintergrund und entfernt diese. Im nächsten Schritt werden „Pixelhaufen“ gesucht die in etwa die gleiche Farbe haben. Sind diese dann Linienartig miteinander verbunden, geht der Algorithmus davon aus dass es sich dabei um Buchstaben handelt.

2. Buchstaben erkennen und Wörter finden

Im nächsten Schritt müssen die gefundenen Buchstaben nun auch noch als solche erkannt werden. Dazu setzt das System einfach auf Erfahrungswerte und versucht, die Buchstaben zu drehen, Helligkeitswerte auszugleichen und so die Form zu erkennen. Dabei hat man das System insbesondere auch mit Buchstaben trainiert, die nicht leicht zu erkennen waren und bei denen die Oberfläche „verschmutzt“ war. Wurden dann die Buchstaben so weit erkannt, werden aus diesen mögliche Wörter gebildet – wobei hier nicht unbedingt jeder Buchstabe korrekt erkannt worden sein muss.

3. Wörter auslesen und übersetzen

Jetzt werden die erkannten Wörter ausgewertet, wobei hier eine selbstständige Fehlerkorrektur zum Einsatz kommt. Da etwa der Buchstabe S mit der Zahl 5 sehr ähnlich ist und das gleiche auch für den Buchstaben O und die Zahl 0 gilt, wird nun in der Datenbank gleich nach mehreren Wörtern gesucht. Dadurch kann das System beispielsweise auch etwas mit dem Wort „5uper“ anfangen und dieses korrekt übersetzen.

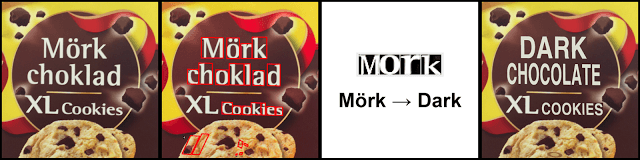

4. Wörter wieder im Originalbild darstellen

Da das Wort nun erkannt und übersetzt worden ist, kennt die Software die genauen Koordination des Wortes und auch die Größe und die Farbe der einzelnen Buchstaben. Jetzt wird versucht durch Einbeziehung des Hintergrunds das Original-Wort zu entfernen – wobei der Hintergrund einfach nur stark verwischt wird. Anschließend wird das übersetzte Wort in einem möglichst ähnlichen Stil darüber gelegt. Fertig ist die Live-Übersetzung.

5. Umsetzung auf mobilen Geräten

Und als wenn das ganze noch nicht beeindruckend gewesen wäre, man muss schließlich bedenken dass dieser ganze Prozess ständig von neuem beginnt wenn das Smartphone bewegt wird, hat man die gesamte Technologie auch noch in die App ausgelagert und für Smartphones optimiert. Diese haben natürlich extrem weniger Leistung als Googles Rechenzentren und sollen aber die gleiche Erkennung bieten, und das ohne eine Internetverbindung zu haben. Dafür hat man das System einfach über lange Zeit trainiert und „an vielen Stellschrauben gedreht“, etwa an der Erkennungs von rotierten Buchstaben – wobei man hier aber natürlich keine Details genannt hat. Dennoch sehr lesenswert!

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter