Google Lens: Multisearch-Funktion kombiniert Bild und Text – startet jetzt auch in Deutschland (Video)

Das Google-Event rund um KI und Websuche ist zu Ende gegangen und hatte eine interessante Ankündigung für Fans von Google Lens und der Bildersuche im Gepäck: Das vor knapp einem Jahr vorgestellte Google Lens Multisearch steht ab sofort für alle Nutzer und mobile Geräte weltweit zur Verfügung. Konkret geht es um die Kombination aus Bild und Text, die nun erstmals in dieser Form möglich sein wird. In einigen Beispielen zeigt sich, wofür man so etwas benötigen könnte.

Die Google Websuche ist kaum mit der Version vor zwei Jahrzehnten zu vergleichen, aber dennoch beginnt nach wie vor jede Suchanfrage gleich: Mit Text. Schon seit vielen Jahren sprechen die Entwickler davon, eines Tages eine multimediale Komponente hereinzubringen und mit anderen Suchtypen beginnen zu können, aber erst jetzt ist es für alle Nutzer weltweit mit Google Lens Multisearch soweit. Denn dieser neue Suchtyp, der bisher nur für US-Nutzer verfügbar war, ermöglicht es auf dem Smartphone (Android und iOS), die Suche mit einem Bild zu beginnen und anschließend mit Text zu verfeinern.

Das klingt sehr praktisch, aber vielleicht fragt sich der eine oder andere, wofür das überhaupt benötigt wird. Die Suche mit Bildern scheint trotz allem noch nicht in der Masse angekommen zu sein, was Google durch viele Entwicklungen rund um Lens ändern möchte. Schon jetzt spricht man von 10 Milliarden Suchanfragen pro Monat, aber – ganz ehrlich – kann ich das nicht wirklich glauben. Sollte es aber so sein, dann bringt Google jetzt ein wirkliches wichtiges und sicherlich von vielen Nutzern verwendetes Update. Es geht vor allem um das Onlineshopping und die Suche nach Produkten.

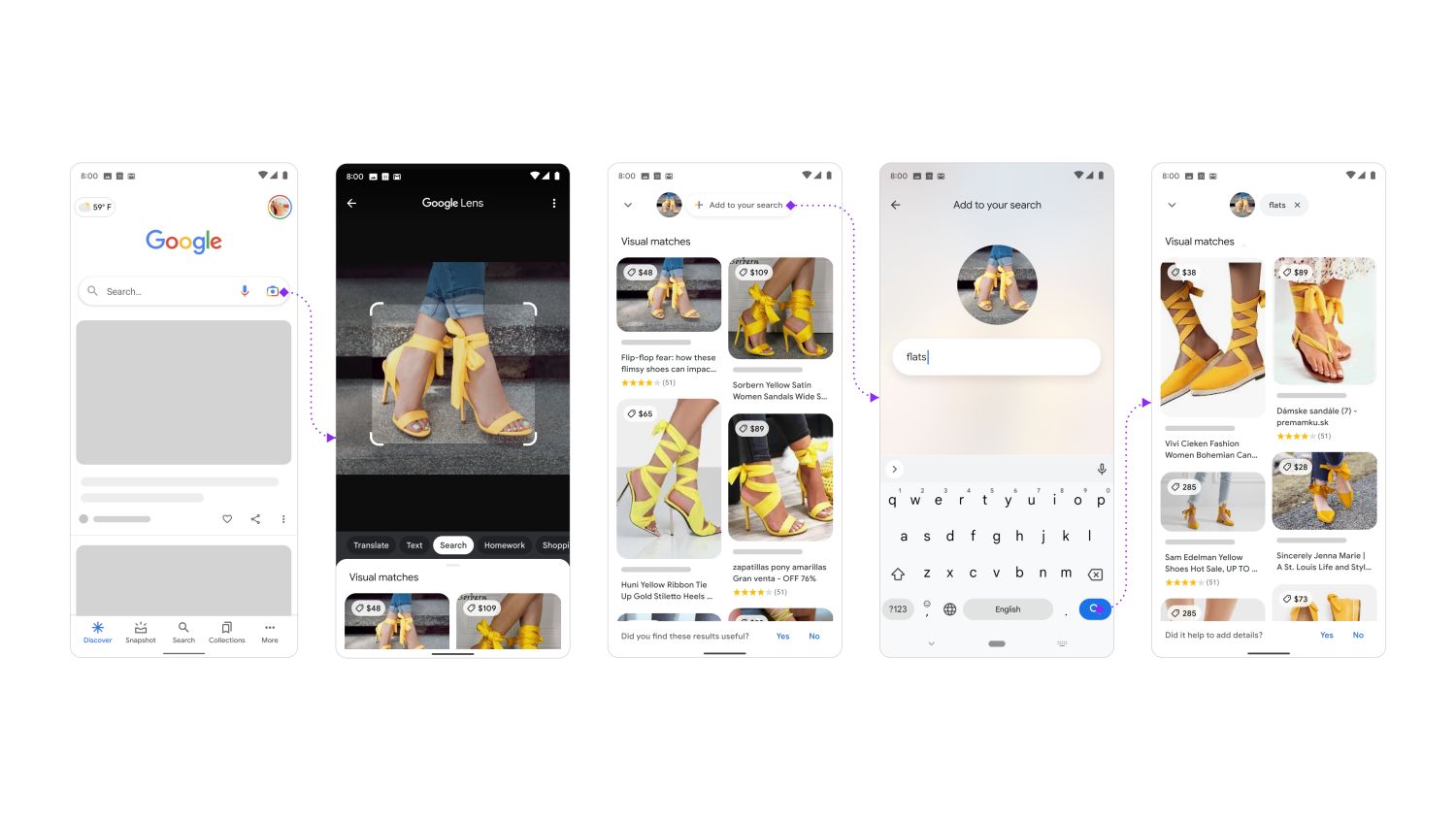

Die Stärke von Lens Multisearch ist es, nach einem Bild oder Objekt zu suchen und die Suchergebnisse anschließend mit einer Suchanfrage zu verfeinern. Man sucht also mit einer Kombination aus Text und Bild, was bisher in dieser Form nicht möglich gewesen ist. Sollen die in gelb gefundenen Schuhe beispielsweise rot sein, dann gibt man das einfach ein und kann darauf hoffen, diese tatsächlich zu finden. Schaut euch die folgenden Beispiele dazu an.

Im obigen Beispiel könnt ihr sehen, wie Google Lens Multisearch auf der Suche nach Schuhen eingesetzt werden kann. Ich bin da kein Experte, aber man kann von hohen Stöckelschuhen zu Schuhen mit einfachen Absätzen und einem ähnlichen Aussehen gelangen. Schuhe scannen, „Flats“ hinzufügen und schon sollte man die gewünschten Bilder und Produkte finden. Vorausgesetzt natürlich, dass diese existieren.

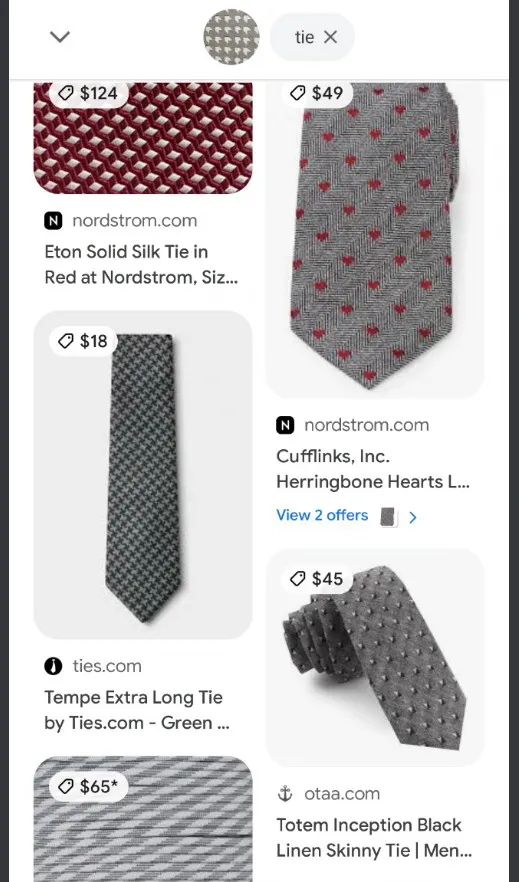

Es müssen nicht nur Damenschuhe sein, sondern auch die Herren dürfen sich freuen: Ein Nutzer hat die Tapete abfotografiert und sucht nach Krawatten mit dem gleichen Muster. Dafür wurde einfach das gewünschte Muster fotografiert, der Suchbegriff „Tie“ hinzufügt und schon darf man das gewünschte Muster um den Hals über den Brustkorb baumeln lassen.

Dasselbe Prinzip funktioniert auch mit anderen Produkten. Im obigen Beispiel wird das Titelmuster eines Notizblocks abfotografiert und über den Suchbegriff „Drapes“ der dazu passende Vorhang gesucht. Scheint zumindest in den Beispielen sehr gut zu funktionieren.

Runden wir das Ganze erneut mit der Mode ab, bei der es diesmal nicht um das Muster, sondern um das gleiche Produkt in einer anderen Farbe geht. Einfach das Kleid auf einem Bild (oder an einer Person) abfotografieren, dann durch die Eingabe von „green“ die gewünschte Farbe angeben und schon kann nach einem sehr ähnlichen Kleid in grüner Farbe geshoppt werden.

—

Ich denke, es wird deutlich, dass das Ganze derzeit vor allem ein Feature für das Onlineshopping ist. Das zeigt sich schon daran, dass die Ergebnisse stets zu der mit Produkten gefüllte Bildersuche führen. Es könnte aber auch in vielen anderen Bereichen funktionieren, bei denen man Bild und Fragestellung kombinieren kann. So könnte man etwas die Kamera auf den Kölner Dom richten und fragen, wann dieser erbaut wurde. Das sollte machbar sein. Oder haltet es auf ein Haustier und fragt nach dessen Ernährung. Über Umwege ist das heute alles schon möglich, aber mit einer Integration wie in obigen Beispielen sehr viel bequemer und damit massentauglich.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter