Android XR: Google zeigt die neuen Gesten für Smart Glasses – so werden sie per Touchpad gesteuert

Google wird in diesem Jahr gemeinsam mit einigen Partnern die ersten Android XR Smart Glasses auf den Markt bringen, die bereits mehrfach präsentiert worden sind. Jetzt wurden interessante Einblicke in die grundsätzliche Bedienung der Gadgets gegeben, die die Nutzer bald im Gesicht tragen soll. Alle Brillen werden unter anderem über ein Touchfeld verfügen, das eine Reihe von Gesten kennt.

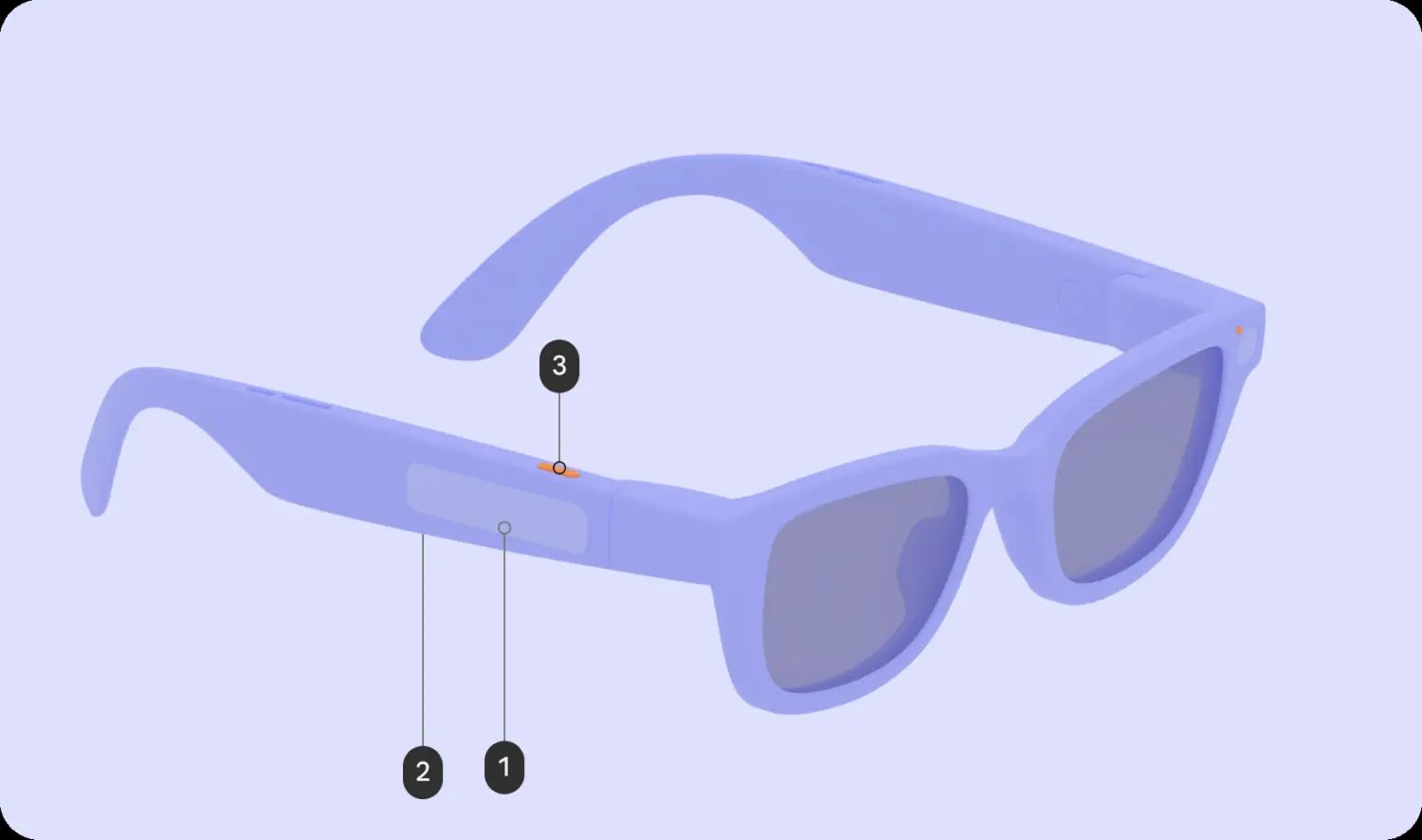

Wir haben euch vor wenigen Tagen die Android XR Smart Glasses etwas ausführlicher vorgestellt, die laut Googles strengen Vorgaben eine Reihe von Buttons und Eingabemethoden mit an Bord haben müssen. Unter anderem werden sie Buttons zum Ein- und Ausschalten, für die Kamera und das Display mitbringen müssen als auch eine Touchfläche am Brillenbügel. Alle Infos dazu findet ihr im verlinkten Artikel.

Die Touchfläche ist auf den Renderbildern recht großflächig und soll eine Reihe von Gesten bzw. Eingabemöglichkeiten unterstützen, mit denen die Nutzer das Betriebssystem Android XR sowie dessen ausgeführte Apps steuern können. In der folgenden Auflistung könnt ihr sehen, welche Gesten geplant sind und wie deren grundsätzliche Funktionalität aussieht. Weil man noch nicht im Blickfeld selbst interaktiv werden kann, muss wieder eine solche Form der Touch-Fernsteuerung zum Einsatz kommen.

- Tippen: Play / Pause / Bestätigen

- Tippen & halten: Gemini starten

- Swipe (Audio): Vor / Zurück / Dismiss

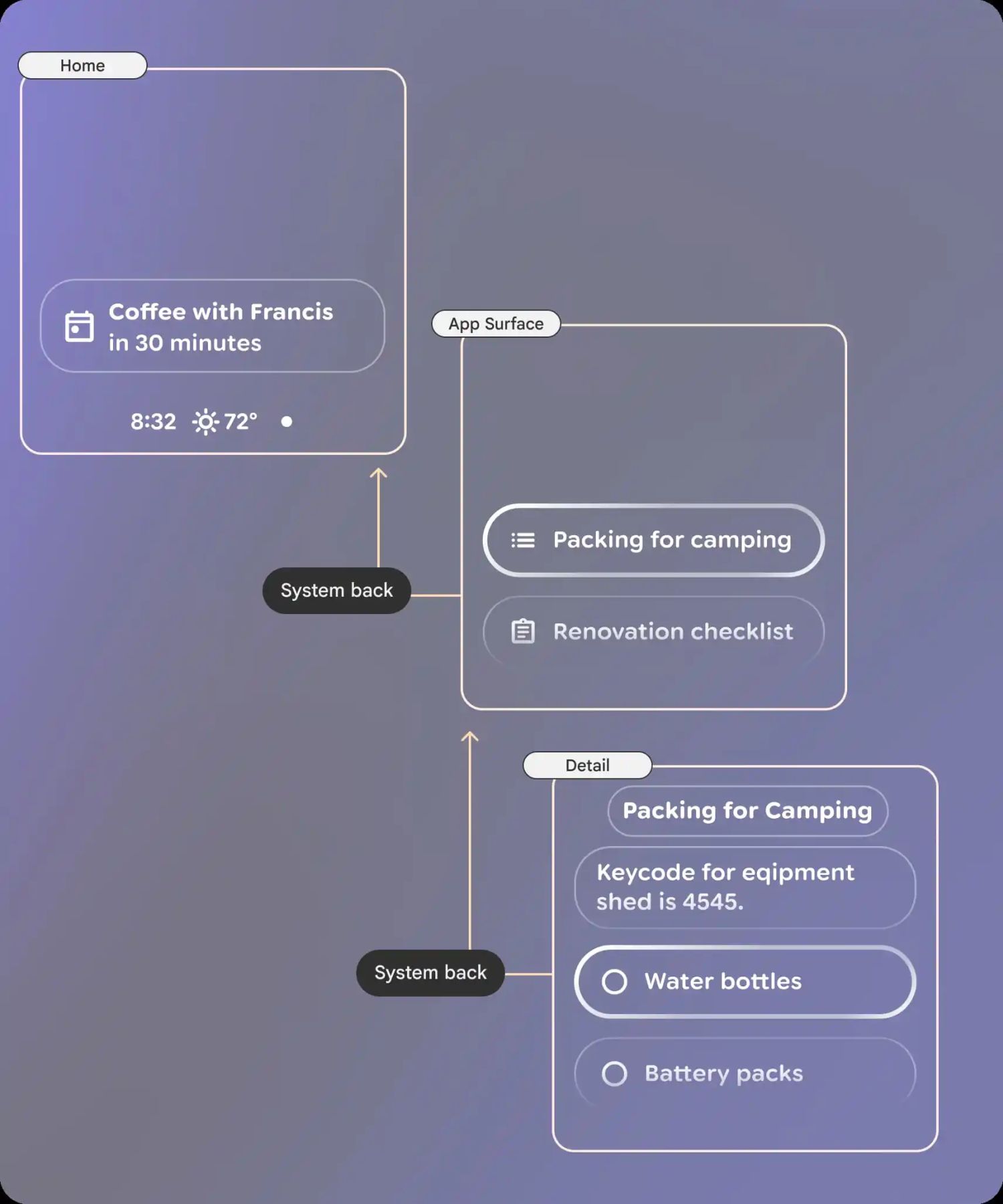

- Swipe (Display): Navigation in der Oberfläche (siehe Screenshot unten)

- Swipe mit zwei Finger: Lautstärke verändern

- Swipe nach unten (Display): Zurück zum Homescreen oder zurück innerhalb einer App (siehe Screenshot unten)

Gesten führen durch die Oberflächen

Nicht alle Gesten dürften auf allen Geräten nutzbar sein. Das liegt daran, dass Google drei verschiedene Android XR Smart Glasses-Typen plant, die sich in der untersten Stufe um ein wichtiges Detail unterscheiden: Sie haben kein Display. Die AI Glasses werden rein verbal gesteuert. Zwar habe sie eine Kamera für die visuelle Aufnahme an Bord, können aber selbst ohne weiteres Hilfsmittel nichts darstellen.

Die Touchsteuerung dürfte daher in diesem Fall andere Aktionen ausführen, die keine visuelle Rückmeldung benötigen. Ähnlich wie das bei smarten Kopfhörern der Fall ist – die bekanntlich auch nicht über ein Display verfügen, kann auch die Brille auf entsprechende Swipes und Taps mit gewissen Aktionen reagieren. In der dazugehörigen Companion-App für die Smartphone-Verbindung dürften sich sicherlich auch Einstellungsmöglichkeiten befinden.

Letzte Aktualisierung am 2026-02-09 / Bilder von der Amazon Product Advertising API / Affiliate Links, vielen Dank für eure Unterstützung! Als Amazon-Partner verdiene ich an qualifizierten Verkäufen.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter