Das DeepWeb wartet: GoogleBot füllt jetzt auch Formulare aus

Der GoogleBot scheint sich mit seiner derzeitigen Spiegelung des Internets nicht mehr zufrieden zu geben und möchte jetzt noch sehr viel mehr Seiten in seinen unendlichen Index aufnehmen: Ab sofort wird der Bot bei einigen ausgewählten Testseiten auch Formularfelder ausfüllen und diese Abfragen absenden. Das könnte für einige Webseiten ganz schön nach hinten los gehen…

Der GoogleBot wird folgendermaßen vorgehen:

Er sieht ein Formular-Feld in der Website, sucht sich 2-3 Wörter die innerhalb der Website vorkommen heraus, und gibt diese in das Formularfeld ein. Dann wird die Anfrage abgesendet und die zurückgegebene Seite auf ihre Relevanz hin überprüft bzw. getestet ob sie nur eine Fehlermeldung oder eine weitere Seite zurückgibt. Auf diese Weise dürfte sich Googles Index innerhalb von wenigen Tagen nahezu verhundertfachen.

Allerdings nimmt der Bot auch Rücksicht: Es werden nur FORM-Abfragen gesendet, wenn die Daten per GET – also über die URL – übertragen werden. POST-Daten rührt der Bot (noch) nicht an. Außerdem wird der Bot natürlich keine unendlichen Anfragen stellen die den Server in die Knie zwingen könnten, die 2-3 herausgesuchten Wörter werden verwendet und dann verkrümelt sich der Bot wieder. Beim nächsten Besuch werden dann wahrscheinlich andere Wörter verwendet.

Der PageRank der Webseiten die sich aus diesen Anfragen ergeben beeinflusst übrigens nicht das Ranking der kompletten Seite – wäre ja sonst auch unfair da eine Menge Duplicate Content entstehen würde. Hier im Blog würde der Bot z.B. das Suchformular ausfüllen und würde Artikel geliefert bekommen die eh schon im Index sind. Außerdem wurden Suchanfragen, sofern sie irgendwo verlinkt waren, eh schon seit langer Zeit im Index geführt.

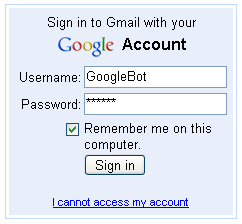

Das Problem für den Webmaster könnte jetzt sein, dass an dieser Stelle Seiten aufgelistet werden die nicht für jedermann zugänglich sein sollten. Da der Bot eine unendliche Geduld hat und sozusagen ständig bei jedem Besuch neue Anfragen ausprobiert, könnte es passieren dass ehemals geschützte Seiten plötzlich offen im Index herumschwirren. Ich denke es gibt nicht wenige Seiten die selbst den Login per GET ausführen…

Was haltet ihr von der Funktion? Ich bin der Meinung dass ein neues HTML-Tag innerhalb von FORM her muss dass den Suchmaschinen das parsen erlaubt oder verbietet. In dem Falle dann gerne auch mit POST.

» Ankündigung im Webmaster Central Blog

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Hmm packt doch einfach die Ziel-URL deines Formulars in die robots.txt …

Ich denke auch dass die neue Bot-Funktion eher nützlich ist. Wenn ein Webmaster „offen“ ehemals geschützte Seiten umliegen lässt, ist er selber schuld und solange POST-Daten sicher sind, hat man ja auch ne ganz klare Option. Bin aber mal gespannt ob der Bot diesbezüglich auch ausgebaut wird

Natürlich ist der Webmaster selbst schuld – aber das ist er eh immer. Und ich wette dass es Tausende, wenn nicht Millionen, Webseiten gibt die sensible Daten auch via GET ausgeben… Und für die wird das ein Riesenproblem werden.

Ich stimme da eher CB und JOhannes zu – Wer z.B. eine Passwortabfrage per GET Realisiert ist selber Schuld 😉 Ich würde es ganz gut finden, wenn die Funktion standardmäßig deaktiviert sein wird und sich mit den Webmaster Tools freiwillig aktivieren lässt. Oder von mir aus auch standardmäßig aktiviert aber deaktivierbar.

Gruß,

foxx

Aus ~25Milliarden Seiten sollen binnen Tagen 2.5Billionen werden? Das würde sicher auch GFS, Map Reduce und Co sprengen.

Google wird es darum gehen, dass es Links auf Seiten entdeckt die hinter einem Formular „versteckt“ sind und sonst nicht in der Seite verlinkt, z.B. auf einer Maklerhomepage die Angebote.

Ich wäre auch für ein HTML-Tag, dass dem Bot das Ausfüllen eines Formulars erlaubt. Wenn dieses Tag fehlt, soll der Bot das Formular nicht anrühren.

Macks

Ich finde den Vorschlag von foxx sehr gut! Kann mich dem nur anschließen so wäre es sicherlich am leichtesten.

Nimm doch nur mal das Beispiel Suchanfragen: Da kannst du aus den 36.200 Seiten aus die der Blog hier besteht leicht ein paar Millionen Seiten machen – musst nur eine Suchanfrage durchführen und bekommst so immer wieder andere Inhalte.