Die Augen des Google Assistant: Google Lens ist weit von dem entfernt, was mal versprochen wurde (Video)

Google stellt immer wieder neue Produkte vor oder liefert Vision und Zukunftsaussichten für bereits bestehende Dienste. Diese Aussichten wissen sehr oft zu begeistern, scheinen aber eher auf dem Wunschdenken der Produktmanager statt der Realität zu basieren. Am Beispiel von Google Lens und auch Google Fotos wird deutlich, dass die Machbarkeit bei den Präsentationen nicht unbedingt die größte Rolle spielt. Vor allem Lens ist weit von dem entfernt, was vor langer Zeit versprochen wurde.

Die vor über eineinhalb Jahren versprochene Colorierung von Schwarz-Weiß-Fotos wird schon bald endlich ihren Weg zu Google Fotos finden und den Nutzern eine entsprechende Funktion bieten – allerdings vorerst in einem Beta-Stadium. In einem früheren Interview hieß es, dass die Ergebnisse damals nicht zufriedenstellend waren und das gesamte Feature zurück auf das Reißbrett musste. Und dann wollen wir auch nicht das Entfernen von Objekten auf Fotos vergessen.

Google Lens ist ohne Frage ein sehr praktisches Tool, das Millionen von Objekte erkennen und dem Nutzer benennen und mit weiteren Informationen beschreiben kann. Die dahinterstehende Technologie kommt unter anderem auch bei Google Lookout für sehbehinderte Menschen zum Einsatz, bringt für alle anderen Nutzer aber kaum Vorteile. Nach einigen Testläufen hat man das Tool kennengelernt, war vielleicht auch beeindruckt, wird es im Alltag aber wohl kaum benötigen. Außerdem kann Google Lens nun in Kombination mit der neuen Texterkennung in Google Fotos viele Texte kopieren.

Bis heute ist Google Lens nicht viel mehr als ein aufgebohrtes Google Goggles, das schon damals Objekte erkennen konnte, mit denen Lens bis heute Probleme hat. Am Beispiel von Goggles zeigt sich aber auch, dass die Objekterkennung für die meisten Menschen vollkommen uninteressant ist. Die paar Augenblicke im Jahr, bei denen man es vielleicht benötigen würde, wird man mit Sicherheit nicht daran denken oder hat keine Möglichkeit, die Plattform zu nutzen.

Ein immer wieder beworbenes Einsatzgebiet ist die Erkennung von Sehenswürdigkeiten, die man auf den ersten Blick vielleicht nicht benennen kann. Wer sich aber unterwegs in anderen Ländern befindet, hat häufig keine Internetverbindung und kann somit auch Google Lens nicht nutzen. Für was ist Google Lens also überhaupt nutzbar?

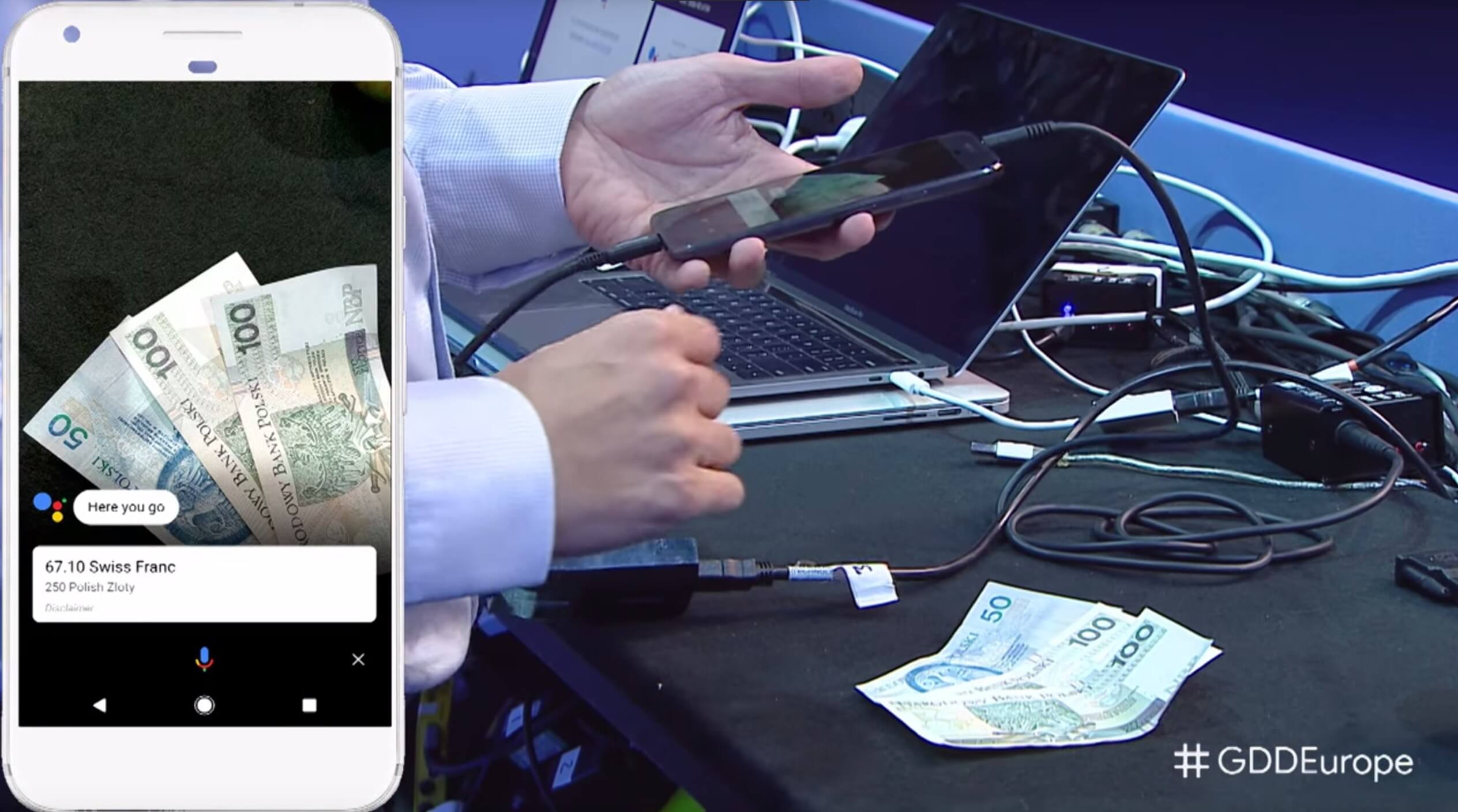

Bereits im September 2017 hat Google auf der Bühne gezeigt, was mit Google Lens zukünftig möglich sein soll. Das ist nun gute zwei Jahre her, aber bis heute sind wir noch einmal in die Nähe dessen gekommen, was damals mit einer Live-Demo gezeigt wurde. Vermutlich war es also keine echte Demo, sondern ein zuvor programmierter Ablauf, denn bis zu den gezeigten Ergebnissen ist es noch ein sehr weiter Weg, den die Entwickler wohl nicht mal eben so im vorbeigehen freischalten können.

Auf der großen Bühne wurde unter dem Erstaunen der Zuhörer gezeigt, wie ein Bündel Geldscheine mit Google Lens gescannt und dann deren Wert in der eigenen Währung genannt wird. Dazu sind viele Schritte notwendig: Zuerst muss das bunte Papier als Geld erkannt werden, dann muss die Währung und der jeweilige Wert der einzelnen Geldscheine erfasst werden. Anschließend müssen die Scheine summiert werden, die Währung umgerechnet und dann das Ergebnis ausgespuckt werden. Allein schon beim ersten Schritt hat Lens manchmal Probleme.

In obigem Video, ab Minute 52 wird es interessant, ist diese und eine weitere Demo zu sehen. Als zweites Beispiel wird ein Apfel vor die Kamera gehalten und dessen Kaloriengehalt abgefragt. Die Erkennung eines Apfels bekommt Lens mittlerweile recht gut hin, aber damit hört es dann auch schon wieder auf. Die Sorte sowie die Größe bleibt Lens in den allermeisten Fällen schuldig, sodass auch keine halbwegs zuverlässige Kalorienangabe möglich ist.

Wäre so etwas tatsächlich möglich, könnte man eines Tages auch im Restaurant die Pizza mit ihren gut sichtbaren Belag scannen und sofort wissen, wie viel Kalorien man sich damit in etwa zumuten wird. Niemand erwartet exakte Werte, das ist wohl auch unmöglich, aber Google Lens ist noch nicht einmal in der Nähe eines solchen Funktionsumfangs. Fraglich, ob das überhaupt jemals funktionieren wird.

Niemand erwartet von Google Lens große Wunder, aber wenn man etwas mit einem realen Produkt zeigt und somit gewissermaßen ankündigt, sollte man vielleicht realistisch bleiben und nicht gleich 10 Jahre in die Zukunft springen. Diesen Fehler macht Google aber des Öfteren und schafft sich somit selbst Probleme. Die Menschen sind dann zwar begierig auf das neue Produkt, aber genauso enttäuscht, wenn sie dann den Unterschied zur Präsentation sehen. Ein weiteres Beispiel dafür waren auch die Google Duplex-Telefongespräche, die nicht funktionieren.

Und nun hat Google ein über viele Jahre entwickeltes Produkt im petto, das eigentlich sehr vielversprechend wäre, aber wohl kaum Nutzer findet. Anders lässt es sich nicht erklären, dass Lens nun in die Suchleiste kommt und schon sehr bald auch im Chrome-Browser zu finden sein wird. Das sind praktische Integrationen, aber sie rühren eher daher, Lens mehr Aufmerksamkeit zu verschaffen. Am Funktionsumfang hat sich aber seit langer Zeit nichts mehr getan.

Bleibt also weiter zu hoffen, dass Lens irgendwann einen großen Sprung macht und die Erkennung deutlich verbessert und die Möglichkeiten mit den erkannten Inhalten und Objekten ausgebaut werden. Die Integration in Google Go ist schon ein sehr guter Schritt.

» Google Lens: Die Augen des Google Assistant kommen in den Chrome-Browser & in die Android-Suchleiste

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Aber das war doch schon immer so. Alle Firmen (und oft auch deren Gründer / Chefs persönlich) rühren mit einer Trommel an die so riesig ist, das man der Science-Fiction oft nur noch ein müdes lächeln abgewinnen kann.

Akkus wurden noch immer nicht zum Superspeicher, obwohl unter anderem Elon Musk uns das versprochen hat.

KI rettet noch keine verhungernden Menschen und hat auch noch keine Terminatoren geschaffen, obwohl uns das eine versprochen und vor dem anderen eindringlicher als vor der Klimaerwärmung gewarnt wird.

Personenerkennung mit Kameras hat Fehlerquoten die viel Arbeit erfordert, die false positives „auszufiltern“.

Autos sind noch millionen von Meilen davon entfernt, selbständig auf nicht zuvor schon tausendfach abgefahrenen und vermessenen Strecken zu fahren.

Sprachbefehle müssen noch immer im grossen Stil von Menschen analysiert werden, damit das seit Jahren vorhandene System einigermassen brauchbar ist. Trotzdem ist es noch immer sehr statisch und hat eine extrem syntetische Stimme, also weit entfernt vom „Helfer“ der uns vor Jahren versprochen wurde.

Morgen wird der Mars „terraformed“ und übermorgen leben Menschen auf dem Planeten (ich hoffe das schon die erste Rakete riesig sein wird, es können gar nicht genügend Meschen darin Platz haben).

Atom-Strom war auch nicht die allheilbringende Lösung für die Stromproduktion, wie man es damals versprochen hat.

Plasmareaktoren sind immer noch „beta“.

Meine Vermutung ist, dass die ganze „Augenwischerei“ eher für die Menschen am Aktienmarkt gedacht ist (klar, fallen die „normalos“ darauf rein, hilft das auch wieder den Aktien-Menschen, deshalb auch für die anderen).

Von Google nutze ich nur noch die Core-Dienste (Mail, Kalender, Kontakte, Drive) intensiv, alles andere ist Spielzeug und nichts worin ich viel Zeit investieren würde.

Google Lens ist unheimlich praktisch wenn man Defekte No Name Ware hat. Bspw. Hatte ich eine Tasse die irgendwann dann in der Spülmaschine gesprungen ist mit Google Lens hab ich das Motiv gescannt und sofort einen Link zu Amazon bekommen mit der gleichen Tasse. Auf der Tasse war ein schwer beschreibbares geometrisches Motiv weshalb eine Suche über Amazon direkt zu viele Ergebnisse lieferte um sie manuell zu sichten. Außerdem erhielt ich 3 weitere Links zu der Tasse bei anderen Anbietern. Das funktioniert auch mit Screenshots. Entsprechend könnte man auch Preise vergleichen. Gleiches Problem hatte ich mit einer Kette die ich meiner Freundin irgendwann für 3€ in Spanien gekauft habe… Sie hing sehr daran da es unser 1. Gemeinsamer Urlaub war, ich musste zwar das 10fache im Netz zahlen aber eine glückliche Freundin heißt ein entspanntes leben 😉

Ich lasse ständig nach Pflanzennamen suchen. Anhaltend beeindruckend. Sogar unser Hund den ein Verwandter ohne Plan aus einem Kofferraum in Polen kaufte, konnte identifiziert werden und das war wirklich beeindruckend, keiner sonst hatte auch nur eine Idee, die der Realität nahe kam.

Hallo Jens!

Ich bin der Author von Google Lens.

Danke fuer den kritischen und ehrlichen Blogpost.

Die Demos on Stage sind alle real aber funktionerten nur in sehr begrenztem masse (Es waren Prototypen) und daher wurden sie nie weiter verfolgt.

Lens hat mehr als 1B queries beantwortet und ist oft sehr hilfreich.

Sie erwaehnten auch Google Go wo Lens speziell fuer Benutzer optimiert ist die vielleicht die regionale Sprache nicht kennen oder nicht lesen koennen.

Zum Beispiel: https://www.youtube.com/watch?v=ePwKgKp69GE

Das ist eine echte Userstory.

Gruesse aus Google@Zurich.