Google Lens: So funktioniert die neue intelligente Bilderkennung des Google Assistant [Video]

Auf der großen Entwicklerkonferenz Google I/O wurde das neue Tool bzw. die Plattform Google Lens angekündigt, mit der die Erkennung von Fotos und Livebildern auf eine neue Ebene gehoben werden und fest in die Google-App integriert werden soll. In der aktuellen Beta-Version ist dieses Tool nun schon integriert und konnte von Bastlern bereits aktiviert werden. In einem Video ist nun zu sehen, wie Lens funktionieren wird.

Die Erkennung von Bildern und Objekten ist schon seit langer Zeit ein Schwerpunkt von Googles Bemühungen und findet sich unter anderem in Tools wie Google Photos wieder. Doch statt eine solche Funktion in einzelne Apps zu integrieren, wird nun eine Plattform geschaffen, auf die andere Apps zugreifen können, die leicht mit Künstlicher Intelligenz verbunden werden und vielleicht auch von externen Anbietern mit Daten gefüttert werden kann.

Schon vor einigen einigen Wochen wurde bekannt, dass der Google Assistant Augen bekommt und auf Lens zugreifen kann – und jetzt zeigt sich auch, wie das ganze aussehen wird. Mit einem Touch auf das derzeit noch leicht deplatzierte Kamera-Symbol in der Suchleiste wird die Kamera geöffnet, und der Nutzer kann das Smartphone auf einen beliebigen Gegenstand halten. Anschließend wird dann auf diesem Bild nach Inhalten gesucht, über die der Nutzer mehr erfahren kann.

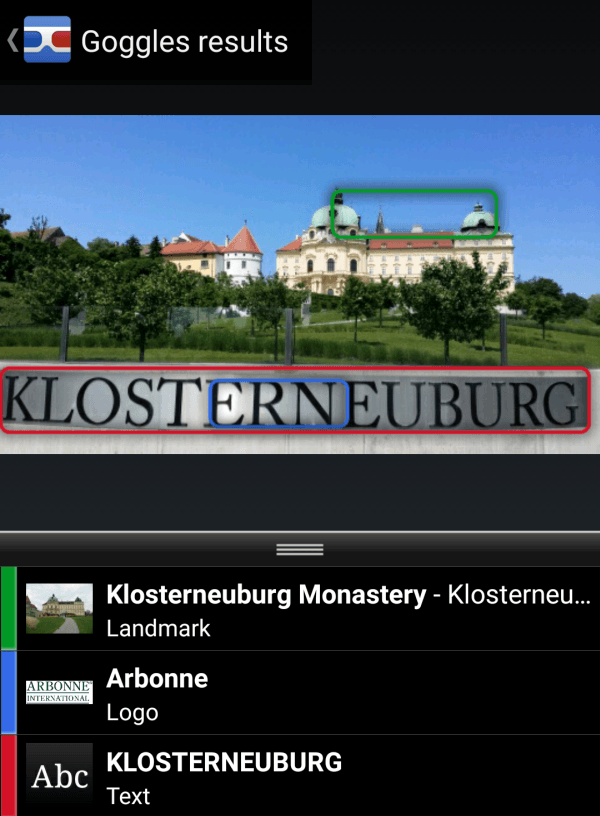

Derzeit funktioniert das großteils nur mit Texten und Wörtern, die auf dem Bild markiert und dann zum Suchen oder Kopieren verwendet werden können. Schon bald sollen aber auch viele andere Dinge erkannt werden können, so dass auch Gegenstände, Sehenswürdigkeiten, Landschaften und vielleicht sogar Personen markiert und korrekt beschrieben werden. Auch eine Erkennung einer Szenerie ist für die Algorithmen eigentlich kein Problem mehr, bisher ist die angeschlossene Intelligenz aber wohl noch nicht scharf geschaltet.

Aktuell funktioniert das ganze so, wie man es von der Screenshot-Funktion des Assistenten kennt, der zum aktuell angezeigten Inhalt passende Websuchen und Informationen vorschlägt.

Der Funktionsumfang ist zwar derzeit noch nicht einmal so groß wie der von Google Goggles vor vielen Jahren, aber das kann durch die serverseitige Aktivierung natürlich sehr schnell geändert werden. Da Google das Tool bis heute nicht eingestellt hat, könnte ich mir vorstellen dass es noch immer von einigen Nutzern verwendet wird (ich nutze es zum Scannen von QR-Codes) und dann wohl nach dem Start von Lens in die Google-App aufgeht.

Wann genau Lens gestartet wird ist noch nicht bekannt, aber es hebt den Assistant und die Websuche wieder auf eine neue Stufe – was allein schon durch die Platzierung des Icons neben dem Mikrofon-Symbol unterstützt wird. Auch die Verwendung der Bilderkennung wird endlich etwas sinnvoller gestaltet, denn bisher verwendet Google die Informationen ausschließlich intern: Die Bildersuche kann nach ähnlichen Fotos suchen und Google Photos kann Bilder eindrucksvoll sortieren, aber den Inhalt selbst nicht beschreiben.

Da die Funktion nun fest in die Google-App integriert ist, dürfte es wohl nicht mehr lange dauern bis Lens endgültig ausgerollt wird – ob es dann noch immer unter diesem Namen gestartet wird, steht derzeit noch nicht fest.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter

Wie schafft ihr es, dass dieser Google Now Feed Wie im Video zu sehen ist ? Bei mir ist da rein gar nichts von dem und ich bin in der Beta

Das Video stammt aus einem Teardown und die Funktionen wurden jeweils durch einen tiefen Eingriff in den Quellcode der App freigeschaltet. Noch ist das in der Form nicht verfügbar.