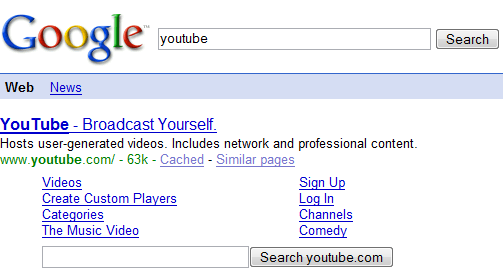

Vor 3 Wochen hat die Website-Suche unter den Sitelinks eingeführt - und jetzt beschweren sich die ersten Geschädigten darüber: Dadurch dass das durchsuchen der Website jetzt auch auf Google-Servern abläuft, entgehen der Website nicht nur Traffic und damit verbundene Werbeeinnahmen, sondern - schlimmer noch - es werden auch in dieser Suche Anzeigen von der Konkurrenz angezeigt.

Vor 3 Wochen hat die Website-Suche unter den Sitelinks eingeführt - und jetzt beschweren sich die ersten Geschädigten darüber: Dadurch dass das durchsuchen der Website jetzt auch auf Google-Servern abläuft, entgehen der Website nicht nur Traffic und damit verbundene Werbeeinnahmen, sondern - schlimmer noch - es werden auch in dieser Suche Anzeigen von der Konkurrenz angezeigt.

Die Unternehmen die sich über diese Funktion beschwert haben wurden nicht näher genannt - aber ich kann sie vollkommen verstehen. Durch die Suchfunktion auf der eigenen Seite kann man natürlich Statistiken darüber führen was die User für Content suchen und damit wollen bzw. worauf man sich selbst konzentrieren sollte. Natürlich entgehen auch dadurch jede Menge Werbeeinnahmen - gerade innerhalb von Suchergebnissen wird Werbung sehr häufig angeklickt. Schlimmer aber ist, dass in dieser Seiten-Suche natürlich auch AdWords-Banner angezeigt werden die von der Konkurrenz geschaltet worden sind. Wer Microsoft.com nach "Windows" durchsucht und dann - weil er ein DAU ist - auf einen Banner klickt landet dann halt auf einer Linux-Seite. (Und ich habe DAUs sehr oft dabei beobachtet wie sie Suchergebnisse mit Bannern verwechseln...) Schlecht dabei ist natürlich auch dass die daraus resultierenden Werbeeinahmen nicht mehr an die Website sondern direkt an Google gehen. P.S. Hat jemand eine Ahnung warum YouTube und Microsoft diese Suchbox besitzen und z.B. Yahoo!, Google und GoogleWatchBlog nicht? Alle Suchen besitzen Sitelinks. [heise]

Benutzer der

Benutzer der

Im Dezember 2007 wurde circa

Im Dezember 2007 wurde circa

Manchmal kommt es vor, dass man einen Blogpost erst zu einem bestimmten Zeitpunkt in der Zukunft veröffentlichen möchte, etwa zu einer Nachtschlafenden Uhrzeit oder bei Urlaubsabwesenheit. Zusammen mit der

Manchmal kommt es vor, dass man einen Blogpost erst zu einem bestimmten Zeitpunkt in der Zukunft veröffentlichen möchte, etwa zu einer Nachtschlafenden Uhrzeit oder bei Urlaubsabwesenheit. Zusammen mit der  vs.

vs.