Project Soli: Googles ATAP-Abteilung zeigt revolutionäre Erkennung von Hand- und Fingergesten

Bisher war Googles ATAP-Abteilung (Advanced Technology And Projects) vor allem für das Project Tango-Tablet bekannt, das nun mittlerweile auch in den offenen Verkauf gegangen ist. Doch Hinter den Kulissen wird natürlich noch an vielen weiteren Projekten gearbeitet, wovon nun ein neues auf der Google I/O vorgestellt worden ist: Das Project Soli kann Gesten der Hand des Menschen erkennen und schickt sich an, die gesamte Interaktion mit technischen Geräten zu revolutionieren.

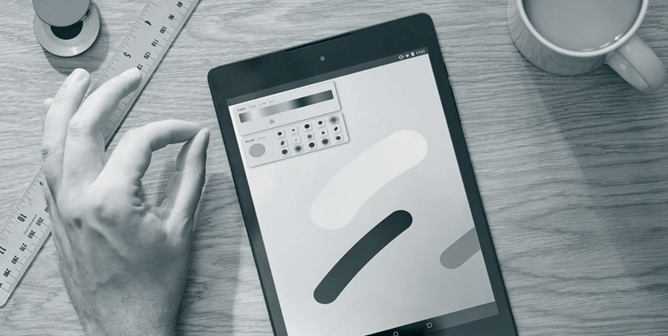

Während wir noch vor wenigen Jahren die Maus in der Hand halten mussten, hat sich durch die Etablierung von Touch durch die Smartphones die Interaktion mit unseren technischen Geräten schon einmal stark verändert, und Google arbeitet schon an der nächsten Revolution: Das Project Soli hat es sich zum Ziel gesetzt, dass wir zukünftig auch mit Gesten Aktionen auslösen können, ganz so als wenn es tatsächlich physikalische Eingabemöglichkeiten gibt.

Schaut euch das Video unbedingt an, da es sehr gut die Funktionsweise von Soli beschreibt. Durch Radar-Technik wird die Hand und jeder einzelne Finger des Nutzers getrackt und deren Bewegung ausgewertet. Dadurch kann der Mensch normale Bewegungen wie etwa beim Drücken eines Knopfes, Schieben eines Reglers oder Drehen eines weiteren Knopfes ausführen und Soli kann dies auswerten und in die eigentliche Interaktion umwandeln. Die gesamte Technologie passt dabei in einen winzigen Chip und kann so problemlos schon heute in ein Smartphone integriert werden.

Doch das eigentliche Ziel dürfte nicht unbedingt die Steuerung eines Smartphones ohne Berührung des Displays sein – was auch heute schon durch Handgesten möglich ist – sondern dürfte sich vor allem auf VR und AR beziehen. Mittlerweile gibt es etablierte Technologien um dem Nutzer sowohl Informationen als auch Interaktionsmöglickeiten einzublenden – doch für diese müssen derzeit noch sehr deutliche Gesten durchgeführt werden. Mit dem Project Soli könnte dem Nutzer eine gesamte Oberfläche eingeblendet werden, mit der er normal interagieren könnte als wenn sie wirklich da wäre – und das ganze ohne Handschuhe oder viele Tracking-Kameras.

In welche Richtung sich das ganze auch immer entwickeln wird, mit dem Project Soli macht Google einen weiteren wichtigen Schritt. Filme wie Minority Report wären in der Form mit all den erforschten Technologien schon heute möglich, wenn vielleicht auch noch nicht ganz so opulent wie in Hollywood. In dem Beispielvideo zeigt Google vorerst nur den Einsatz bei einem Smartphone, was wohl ebenfalls schon bald kommen könnte, aber viel wichtiger sind die weiteren Einsatzgebiete im Alltag. Jetzt muss Google nur noch herausfinden, wie man diese Technologie tatsächlich sinnvoll einsetzen kann.

GoogleWatchBlog bei Google News abonnieren | GoogleWatchBlog-Newsletter